Роботы – это программы, которые позволяют поисковым системам обходить сайты и анализировать их содержимое. Они играют важную роль в продвижении сайтов, поскольку управляют индексацией страниц и определяют, какие страницы будут показаны в результатах поиска.

Настройка роботов.txt в Битрикс является важным этапом оптимизации сайта. Этот файл позволяет вам указать инструкции для поисковых систем о том, какие страницы должны быть проиндексированы, а какие – исключены из поиска.

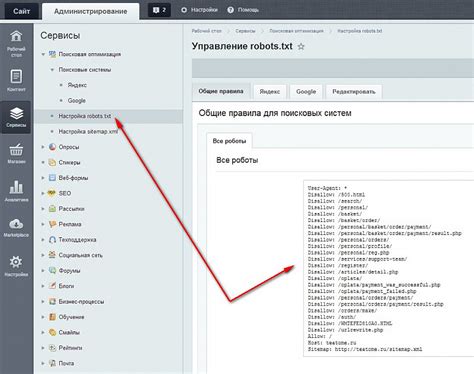

Для настройки роботов.txt в Битрикс вам необходимо открыть Административную панель и перейти в раздел "Настройки". Далее выберите "Настройки модулей" и найдите раздел "Поисковая оптимизация". В этом разделе вы найдете поле для настройки роботов.txt.

В файле роботов.txt вы можете указывать директивы Disallow и Allow, которые указывают поисковым системам, какие URL-адреса следует исключить из индексации или разрешить для индексации соответственно. Также можно использовать директивы Sitemap, чтобы указать местоположение карты сайта для поисковых систем.

Зачем настраивать роботов в Битрикс?

Основная цель настройки роботов - это предоставить поисковым системам ясные инструкции о том, какие страницы вашего сайта индексировать, а какие - нет. Это особенно важно, если ваш сайт содержит дублирующиеся страницы, которые могут негативно влиять на его ранжирование в поисковых системах.

Кроме того, настройка роботов позволяет управлять способом, которым поисковые системы обращаются к вашему сайту. Например, вы можете установить ограничения на частоту обхода сайта роботами, чтобы не перегружать сервер и не приводить к возникновению ошибок.

Настройка роботов в Битрикс также позволяет указать основные параметры для индексации страниц, такие как мета-теги description и keywords, что помогает поисковым системам лучше понимать контекст и цель ваших страниц.

Важно отметить, что настройки роботов могут быть изменены в любой момент, чтобы адаптировать ваш сайт под новые требования поисковых систем или изменения в структуре сайта.

В итоге, настройка роботов в Битрикс является неотъемлемой частью продвижения вашего сайта, позволяя установить ясные правила поисковым системам и улучшить видимость сайта в результатах поиска.

Как настроить роботов в Битрикс для продвижения сайта?

1. Создание файла robots.txt

Первым шагом необходимо создать файл robots.txt, который будет указывать поисковым роботам, какие страницы сайта они могут индексировать, а какие - нет. В Битриксе это можно сделать следующим образом:

- Зайдите в панель управления сайтом в Битриксе.

- Перейдите в раздел "Настройки сайта" и выберите "Настройки и дополнительные возможности".

- В открывшемся окне выберите раздел "Корневая папка сайта".

- Нажмите на кнопку "Добавить файл" и создайте файл с названием "robots.txt".

2. Настройка файла robots.txt

После создания файла robots.txt необходимо настроить его содержимое. Возможные инструкции, которые можно добавить в файл:

- User-agent: указывает на конкретного робота, для которого задаются инструкции. Например, User-agent: Yandex запрещает поисковому роботу Яндекс индексировать определенные страницы сайта.

- Allow: указывает, какие страницы разрешено индексировать. Например, Disallow: /admin/ запрещает индексацию страниц в папке "admin".

- Disallow: указывает, какие страницы запрещено индексировать. Например, Allow: /images/ разрешает индексацию страниц в папке "images".

- Sitemap: указывает путь к файлу sitemap.xml, который содержит информацию о структуре сайта и его страницах.

Пример содержимого файла robots.txt:

User-agent: * Disallow: /admin/ Disallow: /include/ Disallow: /bitrix/ Disallow: /upload/ Disallow: /auth/ Disallow: /search/ Disallow: /*?* Disallow: /*search Disallow: /login/ Disallow: /*.gif$ Allow: /upload/*.jpg Allow: /upload/*.jpeg Sitemap: https://www.example.com/sitemap.xml

3. Создание файла sitemap.xml

Файл sitemap.xml содержит информацию о структуре сайта и его страницах. Создание файла sitemap.xml в Битриксе можно выполнить так:

- Зайдите в панель управления сайтом в Битриксе.

- Перейдите в раздел "Настройки сайта" и выберите "Настройки и дополнительные возможности".

- В открывшемся окне выберите раздел "XML-карта сайта".

- Нажмите на кнопку "Создать XML-карту сайта".

После создания файла sitemap.xml необходимо настроить его содержимое. Для этого можно использовать функционал Битрикса или плагины для создания карты сайта. В файле sitemap.xml должны быть указаны все страницы сайта, подлежащие индексации.

4. Проверка работоспособности файла robots.txt

После создания и настройки файлов robots.txt и sitemap.xml рекомендуется проверить их работоспособность. Это можно сделать с помощью специальных инструментов, например Google Search Console. В Search Console можно загрузить файлы и проверить, будут ли они корректно применены поисковыми роботами.

Настройка роботов в Битрикс для продвижения сайта является важным шагом в оптимизации сайта для поисковых систем. Правильная настройка поможет поисковым роботам эффективно проиндексировать сайт и улучшить его видимость в поисковой выдаче.

Основные настройки роботов в Битрикс для улучшения индексации

Для настройки файлов robots.txt и sitemap.xml в Битриксе необходимо выполнить следующие действия:

1. Настройка robots.txt:

- Зайдите в панель управления Битрикс;

- В разделе "SEO" выберите "Настройки" и перейдите на вкладку "Роботы.txt";

- В открывшемся окне введите путь к файлу robots.txt;

- Нажмите кнопку "Сохранить настройки".

После этого robots.txt будет создан в корне вашего сайта и будет доступен для редактирования.

2. Создание sitemap.xml:

- Зайдите в раздел "Настройки" панели управления Битрикс;

- Выберите вкладку "Карта сайта" и нажмите кнопку "Создать/изменить карту сайта";

- Укажите URL вашего сайта и нажмите кнопку "Начать создание карты сайта";

- После завершения процесса создания карты сайта нажмите кнопку "Сохранить".

Таким образом, вы создадите sitemap.xml, который будет содержать информацию о всех страницах вашего сайта, доступных для индексации поисковыми системами.

Учитывая эти основные настройки роботов в Битрикс, вы значительно улучшите индексацию вашего сайта поисковыми системами. Это позволит повысить видимость и трафик вашего сайта в поисковых результатах.

Роли и настройки файла robots.txt в Битрикс

В Битрикс файл robots.txt можно создать или отредактировать в разделе «Настройки» - «Конфигурация» - «Роботы.txt». В этом файле можно указать инструкции для поисковых систем, которые помогут оптимизировать индексацию сайта.

Файл robots.txt состоит из различных директив (команд), каждая из которых выполняет свою роль в процессе индексации сайта:

- User-agent – определяет для каких поисковых систем предназначена директива.

- Disallow – указывает, какие страницы или разделы сайта не должны индексироваться поисковыми роботами.

- Allow – разрешает индексацию указанных файлов или разделов сайта.

- Crawl-delay – задает задержку между сканированием страниц сайта роботами.

- Sitemap – указывает на файл sitemap.xml, который содержит информацию о структуре сайта и его страницах.

Правильная настройка файла robots.txt поможет улучшить индексацию сайта поисковыми системами и предотвратить индексацию нежелательных страниц. Например, вы можете запретить индексацию страниц с личной информацией пользователей или временных страниц.

После создания или редактирования файла robots.txt в Битрикс, его изменения автоматически отражаются в корневой директории сайта и становятся доступными для поисковых роботов.

Помните, что неправильная настройка файла robots.txt может привести к нежелательным последствиям, таким как неполнота индексации сайта или его полное исключение из результатов поиска. Поэтому, перед внесением изменений, рекомендуется ознакомиться с инструкциями по использованию файла robots.txt и внимательно проверять его настройки.

Как использовать мета-теги в Битрикс для управления поведением роботов

Битрикс предоставляет возможность настраивать мета-теги для каждой страницы вашего сайта. Для этого необходимо выполнить следующие шаги:

- Войдите в панель управления Битрикс.

- Откройте раздел "Сайты" и выберите нужный сайт, для которого хотите настроить мета-теги.

- После выбора сайта откройте раздел "Структура сайта" и найдите нужную страницу.

- Правой кнопкой мыши кликните на страницу и выберите пункт "Редактировать настройки".

- В открывшемся окне найдите раздел "Мета-теги" и заполните соответствующие поля.

В Битрикс можно указать следующие мета-теги:

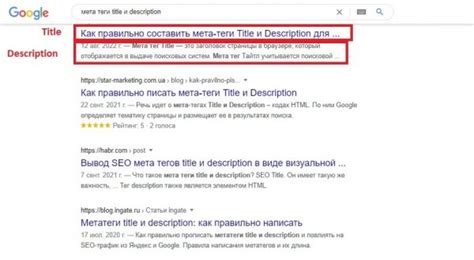

- title – заголовок страницы, который отображается в результатах поиска. Рекомендуется использовать название страницы с ключевыми словами.

- description – краткое описание страницы, которое также отображается в результатах поиска. Содержимое этого мета-тега должно быть информативным и привлекательным для пользователей.

- keywords – ключевые слова страницы, которые помогают поисковым системам понять контекст страницы. Рекомендуется использовать не более 10-15 ключевых слов.

- robots – указывает роботам поисковых систем, как нужно обрабатывать данную страницу. В Битрикс можно выбрать один из следующих вариантов: "index", "noindex", "follow", "nofollow".

- canonical – указывает на каноническую (оригинальную) версию страницы, если она является дубликатом другой страницы. Этот мета-тег позволяет избежать проблем с дублированием контента в поисковых системах.

После того, как вы заполнили нужные мета-теги, не забудьте сохранить изменения. Чтобы проверить правильность настроек мета-тегов, вы можете воспользоваться сервисами для проверки SEO-оптимизации, например, Seobility или Screaming Frog.

Используя мета-теги в Битрикс, вы можете эффективно управлять поведением роботов поисковых систем, что позволит вашему сайту получить более высокую видимость и привлечь больше органического трафика.

Способы проверки работы настроек роботов в Битрикс

После настройки роботов на вашем сайте в Битриксе важно убедиться, что они работают корректно. Для этого можно воспользоваться несколькими способами проверки:

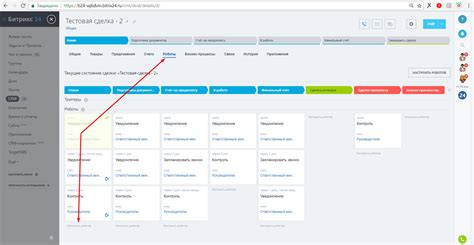

- Проверка работы роботов при тестовых заказах. Создайте несколько тестовых заказов с разными условиями. Убедитесь, что роботы выполняют все заданные действия и отправляют уведомления на указанные адреса электронной почты.

- Проверка работы роботов с помощью симуляции событий. В панели управления Битрикса есть возможность симулировать различные события, например, добавление или изменение элемента. Используйте эту функцию для проверки работы роботов в разных сценариях.

- Проверка работы роботов с помощью журнала событий. В журнале событий вы можете увидеть все активности роботов и проверить их работу. Если робот не выполняет заданные действия или возникают ошибки, вы увидите соответствующие записи в журнале.

- Проверка отправки уведомлений. Если вы настроили роботов на отправку уведомлений на почту или через другие каналы коммуникации, убедитесь, что уведомления действительно отправляются и приходят в нужный формате.

Правильная настройка и проверка работы роботов в Битриксе является важным этапом продвижения вашего сайта. Используйте предложенные способы проверки, чтобы быть уверенным в их правильной работе и эффективности.