Apache Kafka - это распределенная платформа для обработки и передачи потоков данных в реальном времени. Она предоставляет высокую пропускную способность, надежность и масштабируемость, что делает ее идеальным решением для современных архитектур данных.

В этом полном руководстве мы рассмотрим основные компоненты Kafka: источники данных, топики и потоки сообщений. Источники данных - это приложения или устройства, которые генерируют данные и отправляют их в Kafka. Топики - это каналы, через которые данные передаются от источников к потребителям. Потоки сообщений - это процессы, которые обрабатывают данные и выполняют различные операции над ними, такие как фильтрация, преобразование и агрегация.

Apache Kafka предоставляет API для разработки приложений, которые могут использовать эти компоненты. Вы можете писать код на нескольких языках программирования, в том числе Java, Python и Scala. В этом руководстве мы рассмотрим различные способы работы с источниками данных, создания топиков и обработки потоков сообщений с помощью Kafka Streams API.

Если вы заинтересованы в создании эффективных, масштабируемых и надежных систем обработки потоков данных, то это руководство для вас. Мы познакомим вас с основами работы с Apache Kafka, а затем покажем, как использовать его для решения различных задач обработки данных. Начнем!

Что такое Apache Kafka?

Основное преимущество Apache Kafka заключается в его способности обрабатывать большие объемы данных в реальном времени, обеспечивая гарантированную доставку сообщений и отказоустойчивость. С помощью Kafka можно строить устойчивые и масштабируемые системы для обработки событий, потоков аналитики, логирования и других задач.

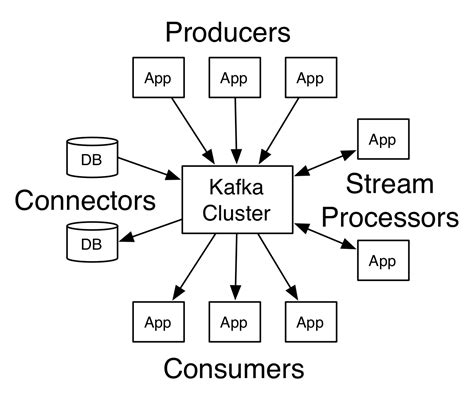

Архитектура Apache Kafka основана на публикации-подписке (publish-subscribe) и работе с темами (topics) и потоками сообщений (message streams). Кластер Kafka состоит из нескольких брокеров (brokers), которые отвечают за хранение и обработку сообщений. Брокеры разделены на различные разделы (partitions), что позволяет распределять нагрузку и обеспечивать масштабируемость.

Клиенты могут записывать сообщения в топики и считывать их оттуда, используя Kafka API. Также Kafka предоставляет возможность управления сообщениями с помощью различных инструментов и библиотек, которые упрощают взаимодействие с платформой.

Важно отметить, что Apache Kafka не является просто системой очередей сообщений, а скорее центральным хранилищем данных, способным обеспечивать надежную и масштабируемую обработку потоков информации.

Ключевые особенности Apache Kafka

Одной из ключевых особенностей Apache Kafka является ее способность обрабатывать и хранить огромные объемы данных в реальном времени. Она может обрабатывать миллионы сообщений в секунду, а также удерживать терабайты данных на одном или более серверах. Это позволяет организациям эффективно работать с крупными потоками данных и строить масштабируемые архитектуры.

Еще одной важной особенностью Apache Kafka является ее отказоустойчивость и устойчивость к сбоям. Она реплицирует данные на несколько узлов, что обеспечивает избыточность и защищает от потери данных при возникновении сбоев. Даже если один из узлов отказывает, система продолжает работать без простоев и сохраняет целостность данных.

Apache Kafka также обладает высокой пропускной способностью передачи данных. Она предоставляет эффективный механизм для отправки и получения сообщений, позволяя обрабатывать большие объемы данных без существенной задержки. Это важно для стриминговых приложений и систем, которым требуется непрерывный и быстрый доступ к данным.

Кроме того, Apache Kafka обладает гибкостью в обработке потоков данных. Она позволяет создавать производителей и потребителей, которые могут быть масштабированы горизонтально и вертикально. Это позволяет быстро и просто масштабировать систему при необходимости увеличения производительности или уровня доступности.

И наконец, предоставляемые Apache Kafka возможности по обработке данных позволяют выполнить широкий спектр задач, включая потоковую обработку, структурированную передачу данных, ретроспективное чтение и сохранение данных на длительное время. Это делает ее полезным инструментом в различных областях, таких как аналитика, обработка журналов, машинное обучение и многое другое.

Источники данных в Apache Kafka

Источники данных в Apache Kafka могут быть различными источниками, такими как:

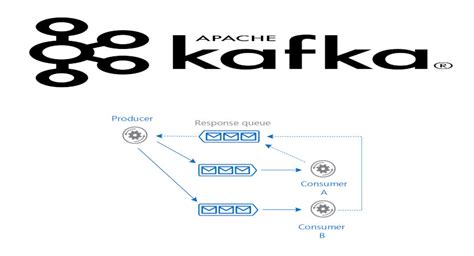

- Производители (Producers): Производители в Kafka отправляют данные в топики (topics). Они могут быть приложениями, сервисами или устройствами, которые генерируют данные и публикуют их в Kafka для дальнейшей обработки.

- Потребители (Consumers): Потребители в Kafka получают данные из топиков и обрабатывают их. Они могут быть приложениями, сервисами или устройствами, которые используют данные для различных целей, таких как анализ, хранение или отображение.

- Источники данных: Источники данных в Kafka могут быть внешними системами или базами данных, которые поставляют данные для записи в Kafka. Эти источники данных могут быть полезными для интеграции Kafka с другими системами.

Источники данных в Apache Kafka играют важную роль в создании цепочки обработки данных, где данные могут быть извлечены, обработаны и использованы для различных задач. Kafka обеспечивает высокую пропускную способность и надежность для источников данных, что делает ее популярным выбором для строя больших систем обработки данных.

Топики и партиции в Apache Kafka

Каждый топик может содержать одну или несколько партиций, которые служат для разделения и распределения нагрузки на производителей и потребителей сообщений. Каждая партиция хранит свою собственную последовательность сообщений в упорядоченном виде, а все сообщения внутри партиции имеют уникальный смещение (offset), которое идентифицирует их в контексте этой партиции.

Партиционирование в Kafka осуществляется с использованием алгоритма хеширования, который определяет, в какую партицию будет записано сообщение. Это позволяет гарантировать, что все сообщения с одним ключом будут находиться в одной партиции и будут обрабатываться в порядке.

Количество партиций в топике может быть настроено при создании, и в дальнейшем его нельзя изменить без создания нового топика. Важно учесть, что количество партиций влияет на пропускную способность и масштабируемость системы. Увеличение количества партиций позволяет увеличить пропускную способность, но также требует больше ресурсов для обработки сообщений.

Топики и партиции в Apache Kafka предоставляют мощный механизм для организации обмена сообщениями между производителями и потребителями. Они позволяют эффективно обрабатывать большие объемы данных, обеспечивать гарантированную доставку сообщений и обеспечивать высокую надежность системы.

Управление потоками сообщений в Apache Kafka

Управление потоками сообщений в Apache Kafka осуществляется с помощью различных инструментов и API.

Для начала работы с потоками сообщений необходимо создать топик - место, где будут храниться сообщения. Затем можно создать производителя (producer), который будет отправлять сообщения в топик, и потребителя (consumer), который будет получать сообщения из топика.

Один из важных аспектов управления потоками сообщений - это обработка ошибок и обеспечение отказоустойчивости. В случае сбоя производителя или потребителя, Apache Kafka позволяет легко восстановить работу системы и продолжить обработку сообщений.

Apache Kafka также поддерживает партиционирование - разделение потока сообщений на несколько частей. Это позволяет распределить нагрузку на разные узлы системы и повысить производительность.

Другим способом управления потоками сообщений в Apache Kafka является использование Kafka Streams API. С его помощью можно создавать и обрабатывать сложные потоки сообщений, выполнять агрегацию, фильтрацию, преобразование данных и многое другое.

Важно отметить, что Apache Kafka предоставляет широкий спектр инструментов для управления потоками сообщений. Гибкость и масштабируемость этой системы делают ее идеальным инструментом для реализации различных сценариев обработки данных.

Потребители и производители в Apache Kafka

Производители в Apache Kafka отвечают за генерацию и отправку сообщений в топики, которые являются логическими единицами организации данных. Они собирают информацию и размещают ее в нужном топике для дальнейшей обработки и распределения. Производители могут быть интегрированы в различные приложения и компоненты, включая базы данных, серверы веб-приложений и многое другое.

Потребители, с другой стороны, служат для чтения и обработки сообщений из топиков. Они предоставляют возможность асинхронного подписывания на один или несколько топиков и позволяют обрабатывать сообщения в порядке их поступления. Потребители могут быть использованы для реализации различных сценариев, например, для стримингового анализа данных, обработки метрик или отправки уведомлений.

Производители и потребители в Apache Kafka работают в асинхронном режиме, что позволяет им обрабатывать большие объемы данных и обеспечивать надежную доставку. Производители могут отправлять сообщения в различные партиции топика, а потребители, в свою очередь, могут обрабатывать сообщения из разных партиций параллельно.

За счет своей масштабируемости и надежности, Apache Kafka стал одним из наиболее популярных инструментов для обработки и передачи данных в реальном времени. Он предоставляет эффективный способ управления потоками данных и обеспечивает надежность и отказоустойчивость системы.

Кластеризация и масштабирование в Apache Kafka

Apache Kafka предоставляет мощные инструменты для кластеризации и масштабирования, позволяющие обрабатывать большие объемы данных и обеспечивать высокую доступность системы.

Кластеризация в Apache Kafka позволяет группировать несколько брокеров в единую систему, создавая высокопроизводительное и отказоустойчивое окружение. Каждый брокер в кластере выполняет роль хранения и обработки сообщений, а также обеспечивает репликацию данных для обеспечения надежности.

Масштабирование в Apache Kafka происходит по двум измерениям: горизонтальному и вертикальному. Горизонтальное масштабирование позволяет добавлять новые брокеры в кластер для увеличения пропускной способности системы и обработки большего количества сообщений. Вертикальное масштабирование предполагает увеличение ресурсов каждого брокера, например, путем увеличения памяти или процессорной мощности, для оптимизации производительности.

Apache Kafka также поддерживает разделение данных на различные топики, что позволяет более эффективно управлять потоками сообщений. Топики могут быть разделены на несколько партиций, которые могут распределяться по разным брокерам в кластере. Это обеспечивает распределение нагрузки и параллельную обработку сообщений.

Для управления кластером и масштабированием в Apache Kafka существуют инструменты, такие как Apache ZooKeeper, которые обеспечивают координацию и обнаружение узлов в кластере. Конфигурационные параметры могут быть настроены для оптимизации работы кластера в зависимости от специфических потребностей проекта.

Кластеризация и масштабирование являются важными аспектами при разработке и развертывании системы на базе Apache Kafka. Благодаря гибкости и масштабируемости Kafka, она может быть успешно применена в различных сценариях, от потоковых аналитических приложений до обработки больших объемов данных.

Надежность и отказоустойчивость в Apache Kafka

В центре архитектуры Apache Kafka находится ядро с рядом брокеров Kafka, которые отвечают за сохранение и обработку данных. Брокеры Kafka работают в кластере, что позволяет обеспечить отказоустойчивость системы. Если один из брокеров выходит из строя, другие брокеры автоматически берут на себя его функции, гарантируя непрерывную работу системы.

Кроме того, Apache Kafka обеспечивает надежность доставки данных. При отправке сообщений в Kafka они сохраняются в специальный журнал (топик), называемый «логом». Лог разбивается на несколько сегментов, что позволяет обеспечить эффективную работу с данными и облегчить процесс восстановления после сбоев. В случае сбоя брокера, Kafka может быстро восстановить работу, используя синхронизированные реплики данных.

Для обеспечения надежности доставки сообщений в Kafka применяется модель подтверждения (acknowledgement). Продюсер получает подтверждение от брокера о доставке сообщения, а если подтверждение получено, продюсер считает, что сообщение успешно доставлено. Если подтверждение не было получено, продюсер повторно отправляет сообщение, чтобы гарантировать доставку.

| Компонент | Описание |

|---|---|

| Продюсер (Producer) | Отправляет сообщения в Kafka. |

| Брокер (Broker) | Хранит и обрабатывает сообщения в Kafka. |

| Консьюмер (Consumer) | Читает сообщения из Kafka. |

| Топик (Topic) | Лог, в котором хранятся сообщения. |

В целях обеспечения отказоустойчивости, Apache Kafka также предоставляет механизмы репликации данных. Репликация позволяет создавать копии данных на нескольких брокерах Kafka, обеспечивая их сохранность даже в случае сбоя одного или нескольких брокеров. Когда изначальный брокер не доступен, выбирается одна из реплик для продолжения работы.

Система сообщений Apache Kafka является надежным и отказоустойчивым решением для обработки потоков данных. Ее распределенная архитектура и используемые механизмы обеспечивают сохранность и доступность данных, а также репликацию и восстановление после сбоев. Это делает Apache Kafka популярным выбором для решения задач связанных с обработкой, хранением и передачей данных в реальном времени.