Файл robots.txt является важной частью оптимизации сайта для поисковых систем. Этот файл позволяет веб-мастерам контролировать доступ роботов поисковых систем к определенным страницам сайта. В Joomla создание и настройка файла robots.txt осуществляется без особых сложностей и требует всего нескольких шагов.

Первым шагом является создание самого файла robots.txt. Для этого необходимо открыть текстовый редактор и сохранить новый файл с именем "robots.txt". Затем необходимо поместить файл в корневую папку вашего сайта, используя FTP или панель управления хостингом.

После того, как файл robots.txt создан и размещен на сервере, необходимо приступить к настройке его содержимого. Одним из основных правил настройки файла robots.txt является указание директив "User-agent" и "Disallow". Директива "User-agent" указывает поисковым роботам, для кого предназначено следующее правило, а директива "Disallow" определяет, какие страницы сайта не должны индексироваться.

Как настроить файл robots.txt в Joomla?

Вот несколько шагов, которые помогут вам настроить файл robots.txt в Joomla:

- Откройте файл robots.txt в корневой директории вашего сайта. Если его нет, создайте новый файл и назовите его robots.txt.

- Добавьте базовую настройку для разрешения или запрета индексации всего сайта. Например:

User-agent: * Disallow:

Этот код позволит всем поисковым системам индексировать все страницы вашего сайта.

- Добавьте дополнительные правила для управления индексацией конкретных разделов или страниц. Например:

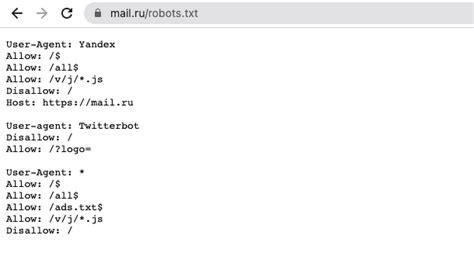

User-agent: Googlebot Disallow: /administrator/ Disallow: /components/ Disallow: /plugins/ User-agent: Bingbot Disallow: /administrator/ Disallow: /components/ Disallow: /plugins/ User-agent: Yandex Disallow: /administrator/ Disallow: /components/ Disallow: /plugins/

В этом примере мы запрещаем индексацию административной панели, компонентов и плагинов для всех популярных поисковых систем.

- Добавьте специфические инструкции для каждой поисковой системы, если это необходимо. Например:

User-agent: Googlebot Disallow: /private/ User-agent: Bingbot Disallow: /private/ User-agent: Yandex Allow: /private/ Disallow: /administrator/ Disallow: /components/ Disallow: /plugins/

Эти инструкции позволяют разрешить индексацию конкретной папки "private" для Yandex, но запрещают ее для Google и Bing.

После настройки файла robots.txt сохраните его и убедитесь, что он доступен по адресу вашего сайта (например, http://example.com/robots.txt). Вы также можете использовать инструменты для проверки настроек robots.txt, чтобы убедиться, что все работает корректно.

Не забывайте, что файл robots.txt не является абсолютной гарантией от индексации страниц вашего сайта. Некоторые поисковые системы, такие как Google, могут проигнорировать правила из этого файла, особенно если веб-мастер не следует правилам протокола "robots.txt". Кроме того, файл robots.txt может быть использован злоумышленниками для поиска уязвимостей вашего сайта.

Будьте внимательны при настройке файла robots.txt и регулярно проверяйте его работу, чтобы быть уверенным в правильной индексации вашего сайта поисковыми системами.

Что такое файл robots.txt в Joomla?

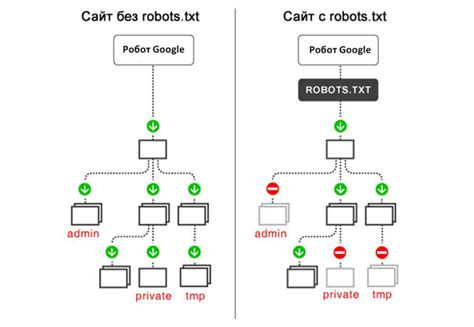

В файле robots.txt указывается, какие страницы сайта можно индексировать поисковым системам, а какие не следует индексировать. Также в файле можно указать директивы для поисковых роботов относительно скорости сканирования сайта, местоположения карты сайта и другой полезной информации.

Для Joomla файл robots.txt может быть настроен специально для оптимизации сайта под поисковые системы. Например, в файле можно указать, что некоторые директории или файлы не должны индексироваться поисковыми роботами, чтобы избежать дублирования контента или показа конфиденциальной информации.

При правильной настройке файла robots.txt можно управлять тем, как поисковые системы индексируют и отображают контент вашего сайта, что может помочь в повышении его видимости и эффективности в поисковых результатах.

Важно помнить, что файл robots.txt является открытым и доступным для всех пользователей, поэтому следует быть осторожными при указании конфиденциальной информации или запрещении доступа к некоторым страницам сайта. Также важно проверять и обновлять файл robots.txt регулярно для адаптации к изменениям структуры сайта или требованиям поисковых систем.

Зачем нужен файл robots.txt в Joomla?

Благодаря файлу robots.txt в Joomla можно скрыть от поисковиков конфиденциальную информацию или содержимое, которое не является релевантным для целевой аудитории. Например, вы можете запретить индексацию страниц с личной информацией пользователей или временных страниц, которые отображаются только во время разработки или тестирования сайта.

Файл robots.txt также позволяет экономить ресурсы сервера. Боты поисковых систем переходят по ссылкам на вашем сайте для индексации его содержимого. Если вы не хотите, чтобы они обращались к определенным разделам или страницам, вы можете указать это в файле robots.txt. Это позволит сэкономить пропускную способность и ресурсы сервера, ускоряя работу сайта в целом.

Еще одним важным аспектом использования файла robots.txt в Joomla является поддержка многопользовательских сайтов. Если на вашем сервере размещаются несколько сайтов на основе Joomla, вы можете использовать отдельный файл robots.txt для каждого из них, чтобы настроить индексацию и исключение для каждого сайта по отдельности.

В целом, файл robots.txt в Joomla - это мощный инструмент для оптимизации вашего сайта в поисковых системах. Он позволяет контролировать, какие страницы индексируются поисковыми системами, и повышает эффективность индексации и обработки вашего контента.

Как создать файл robots.txt в Joomla?

Для создания файла robots.txt в Joomla можно использовать любой текстовый редактор, такой как Notepad или блокнот. Затем следует сохранить файл как "robots.txt" без кавычек и загрузить его на ваш сервер.

Содержимое файла robots.txt зависит от ваших конкретных потребностей и требований. Вот пример базового файла robots.txt:

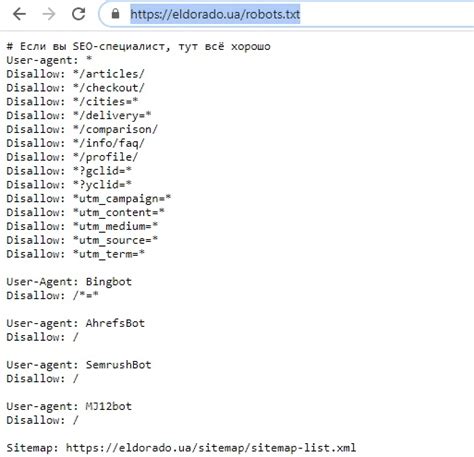

User-agent: * Disallow: /administrator/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/

В этом примере мы запрещаем поисковым роботам индексировать основные директории Joomla, такие как "administrator", "cache", "components" и т.д.

Кроме того, можно добавить дополнительные инструкции, такие как запрет на индексацию конкретных страниц или каталогов, или ограничение доступа поисковых роботов к определенным разделам вашего сайта.

После создания файла robots.txt рекомендуется проверить его на наличие синтаксических ошибок с помощью онлайн-инструментов, таких как "Google Search Console". Затем вы можете загрузить файл robots.txt на ваш сервер с помощью FTP или панели управления хостингом.

Не забудьте, что файл robots.txt не является гарантией для поисковых систем, и они могут выбрать игнорировать его инструкции. Однако, создание и настройка файла robots.txt в Joomla является важным шагом в оптимизации вашего сайта для поисковых систем, поэтому его следует использовать.

Как добавить директивы в файл robots.txt в Joomla?

Для оптимизации сайта в Joomla важно правильно настроить файл robots.txt. Этот файл позволяет контролировать индексацию и обход вашего сайта поисковыми роботами.

Чтобы добавить директивы в файл robots.txt в Joomla, следуйте следующим шагам:

- Откройте файл robots.txt для редактирования. Он находится в корневой директории вашего сайта.

- Вставьте необходимые директивы перед строкой "User-agent: *". Каждая директива должна начинаться с новой строки.

- Сохраните изменения и загрузите обновленный файл robots.txt на ваш сервер.

- Проверьте работу директив. Вы можете использовать инструменты, такие как Google Search Console, чтобы убедиться, что ваши страницы индексируются и обходятся правильно.

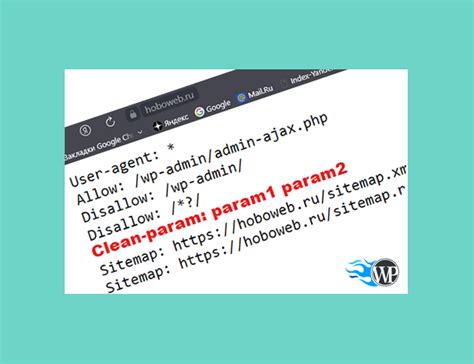

Вот некоторые распространенные директивы, которые можно добавить в файл robots.txt:

- User-agent: * - эта директива указывает на то, что следующие правила применяются ко всем поисковым роботам.

- Disallow: /название_директории/ - эта директива запрещает индексацию всего содержимого указанной директории.

- Disallow: /название_страницы.html - эта директива запрещает индексацию указанной страницы.

- Allow: /название_директории/ - эта директива разрешает индексацию содержимого указанной директории, даже если она была запрещена ранее.

- Sitemap: http://www.example.com/sitemap.xml - эта директива указывает на местоположение файла карты сайта.

Помните, что неправильная настройка файла robots.txt может привести к нежелательным последствиям, таким как неправильная индексация страниц или их полное исключение из поисковой выдачи. Поэтому будьте внимательны и проверяйте свою настройку веб-мастерскими инструментами.

Как запретить индексацию определенных страниц в Joomla?

Веб-мастеры и SEO-специалисты часто сталкиваются с необходимостью запретить индексацию определенных страниц на сайте Joomla. Это может быть полезно, если вы хотите скрыть конфиденциальную информацию, временные страницы или страницы с дублированным или низкокачественным контентом.

Для того чтобы запретить индексацию определенных страниц, вы можете воспользоваться файлом robots.txt. Robots.txt - это текстовый файл, который указывает поисковым роботам, какие страницы сайта они могут или не могут индексировать. В Joomla можно настроить файл robots.txt прямо из административной панели.

Чтобы запретить индексацию определенных страниц в Joomla, следуйте этим шагам:

- Откройте административную панель Joomla и авторизуйтесь.

- Перейдите на страницу "Глобальная конфигурация", которая находится в меню "Система".

- Во вкладке "Конфигурация сайта" найдите раздел "Поисковая оптимизация" и нажмите на кнопку "Нет" рядом с "Использовать robots.txt".

- В появившемся поле введите путь к файлу robots.txt на вашем сервере. Например: /robots.txt. Если у вас нет файла robots.txt, создайте его и загрузите на сервер.

- После этого вы сможете редактировать файл robots.txt, чтобы запретить индексацию определенных страниц. Добавьте следующие строки для каждой страницы, которую вы хотите запретить индексировать:

User-agent: * Disallow: /путь_к_странице/

Замените "путь_к_странице" на реальный путь к странице, которую вы хотите запретить индексировать. Например, если вы хотите запретить индексацию страницы "example.html" в корневой папке вашего сайта, добавьте следующую строку:

Disallow: /example.html

После того, как вы добавили все нужные строки в файл robots.txt, сохраните его и загрузите на сервер. Теперь поисковые роботы не будут индексировать эти страницы.

Запрет индексации определенных страниц может быть полезным инструментом для оптимизации вашего сайта Joomla. Он позволяет вам контролировать, какие страницы будут видны поисковым роботам, а какие нет. Таким образом, вы можете управлять тем, как ваш сайт отображается в поисковых результатах и улучшить общий рейтинг вашего сайта.

Как использовать wildcards в файле robots.txt в Joomla?

Wildcards в файле robots.txt в Joomla позволяют задать общие правила для группы страниц, используя символы "*" и "$". Символ "*" используется для указания любого символа или набора символов в URL, а символ "$" используется для указания конца URL.

Например, если вы хотите запретить индексацию всех страниц в папке "private", вы можете добавить следующую строку в файл robots.txt:

- User-agent: *

- Disallow: /private/

Это запретит поисковым роботам индексировать все страницы, находящиеся в папке "private".

Если вы хотите запретить индексацию всех страниц с определенным расширением, вы также можете использовать wildcards. Например:

- User-agent: *

- Disallow: /*.pdf$

Это запретит индексацию всех страниц с расширением ".pdf".

Использование wildcards в файле robots.txt в Joomla может быть полезным для оптимизации индексации вашего сайта поисковыми системами. Однако, будьте осторожны с использованием wildcards, чтобы не заблокировать нежелательные страницы.

Как проверить правильность работы файла robots.txt в Joomla?

Правильная настройка файла robots.txt в Joomla для оптимизации сайта играет важную роль. Однако, просто создать и разместить файл не гарантирует его правильную работу. Поэтому, необходимо проверить, что robots.txt функционирует и выполняет свои задачи.

Существуют несколько способов проверить правильность работы файла robots.txt в Joomla:

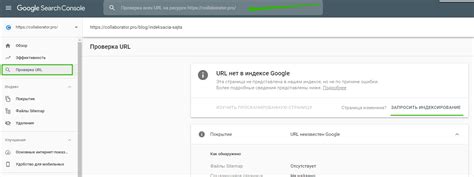

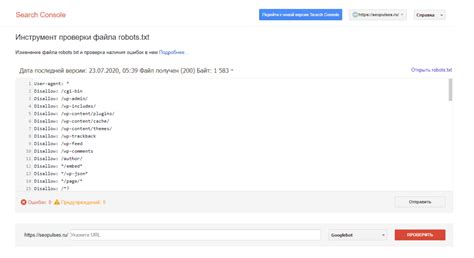

- Используйте "Файл robots.txt" в Google Search Console. Зарегистрируйтесь и подтвердите владение сайтом в Google Search Console. Затем перейдите в раздел "Компоненты" - "Google Search Console" в административной панели Joomla. В этом разделе вы сможете отправить файл robots.txt для проверки. После проверки, Google Search Console покажет, корректно ли работает ваш файл robots.txt и как он влияет на индексацию вашего сайта.

- Используйте "Инструменты для веб-мастеров" Яндекса. Зарегистрируйтесь и подтвердите владение сайтом в Яндекс.Вебмастере. Затем перейдите в раздел "Файлы robots.txt" и введите путь к вашему файлу robots.txt. Яндекс.Вебмастер покажет, корректно ли работает ваш файл robots.txt и как он влияет на индексацию вашего сайта в поисковой системе Яндекс.

- Проверьте содержимое файла robots.txt с помощью онлайн-инструментов. Существуют различные онлайн-инструменты, такие как "Robots.txt Tester" от Google, которые позволяют проверить правильность файла robots.txt. Выполните простую проверку, загрузив ваш файл на такой инструмент и убедитесь, что он не содержит ошибок и правильно блокирует или разрешает доступ к нужным страницам вашего сайта.

Проверка правильности работы файла robots.txt в Joomla является важной частью SEO-оптимизации. Будьте внимательны и убедитесь, что ваш файл robots.txt настроен правильно, чтобы поисковые системы могли корректно проиндексировать ваш сайт.