Математика, как наука, изучает различные аспекты чисел и их взаимодействие друг с другом. Однако, среди всего многообразия чисел есть одно, которое не перестает удивлять ученых - ноль. Именно этому числу посвящен наш научный интерес сегодня. В особенности, нам хотелось бы рассмотреть такое явление, как "ноль на ноль". Почему результат такой операции всегда равен нулю? Что заставляет его оставаться героем множества нулей в математике?

Первая и самая очевидная причина, по которой ноль на ноль равно ноль, заключается в том, что ноль сам по себе не имеет величины. Он олицетворяет отсутствие чего-либо, пустоту. Поэтому, когда мы умножаем ноль на ноль, мы в сущности умножаем ничего на ничего. И какое произведение мы можем получить в результате, если ничего не умножать? Единственно логичный и правильный ответ - это опять же ноль.

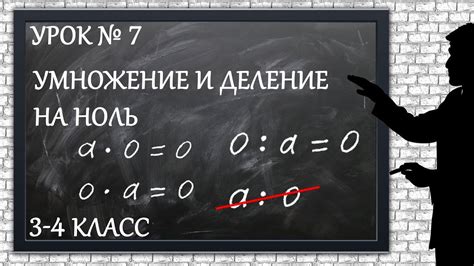

Однако, существует и более глубокое объяснение этому феномену. Ноль на ноль равно ноль из-за особенностей самой математической системы. В математике, есть понятие "аксиомы", которые, по сути, являются неразрешимыми истинами, на которых базируется всё остальное. Одной из аксиом является аксиома произведения нуля. Она гласит, что любое число, умноженное на ноль, дает ноль.

Парадокс нуля на ноль

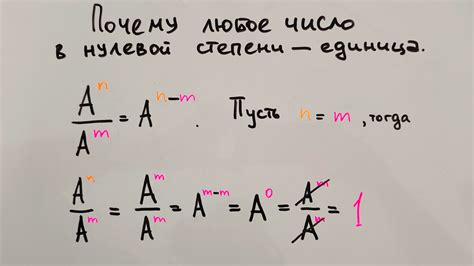

Понятие нуля на ноль вызывает много вопросов и неоднозначностей. Всю историю математики люди задавались вопросом, можно ли определить результат умножения ноля на ноль. Некоторые математики считают, что ноль на ноль должно быть равно нулю, поскольку умножение нуля на любое число дает ноль. Однако другие утверждают, что умножение ноля на ноль должно давать единицу, так как ноль является нейтральным элементом в умножении.

Помимо противоречивых мнений, парадокс нуля на ноль вызывает множество философских рассуждений. Некоторые математики считают, что ответ на этот вопрос не может быть выражен с помощью обычной арифметики, а требует более сложных математических концепций или даже внедрения новых, еще несуществующих понятий.

На сегодняшний день парадокс нуля на ноль остается открытым вопросом и вызывает дискуссии среди математиков. Однако большинство ученых согласны, что нуль на ноль должно быть равно нулю, основываясь на логическом и интуитивном анализе математических законов. В конечном счете, решение этого парадокса может потребовать дальнейшего развития математики и открытия новых концепций.

Почему ноль умноженный на ноль равен нулю?

Для начала, давайте вспомним, что знак умножения обозначает операцию, при которой одно число повторяется определенное количество раз. Например, 2 умножить на 3 означает, что число 2 повторяется 3 раза: 2 * 3 = 2 + 2 + 2 = 6.

Теперь представим, что мы хотим повторить число 0 определенное количество раз. Но ведь что бы мы ни умножили на 0, результат в любом случае будет 0. Почему? Потому что при умножении на 0, любое число "потеряет" свою величину и станет равным 0.

Можно также представить умножение 0 на 0 как умножение числа на "ничто". И если что-то умножено на "ничто", то результатом всегда будет "ничто" - 0. Поэтому ноль умноженный на ноль равен нулю.

Таким образом, причина, по которой ноль умноженный на ноль равен нулю, заключается в самой природе операции умножения и свойства нуля быть нейтральным элементом. Ноль не влияет на результат умножения, он остается нулем вне зависимости от других факторов.

| Умножаемое | Множитель | Результат |

|---|---|---|

| 0 | 0 | 0 |

Исторические корни проблемы

Вопрос о том, что представляет собой ноль и как его интерпретировать, вызывает довольно много интереса и дебатов. Однако, исторически эта проблема имеет свои корни.

Первые записи о понятии нуля можно найти в бережливым взглядах многих астрономов и математиков древней Греции и Индии. По учету ноль использовался как способ обозначения отсутствия какого-либо количества или числа.

Однако, на протяжении многих столетий, ноль вызывал много различных и неоднозначных интерпретаций. Некоторые математики считали ноль нечем иное, как "пустым местом", а другие же рассматривали его как отдельное, самостоятельное число.

Идея о том, что ноль можно считать самостоятельной единицей, не была признана до 9 века н.э., когда арабский математик Мухаммед ибн-Муса ал-Хорезми воспринял эту концепцию и внес ее в свои математические работы. Именно с этого момента началось внедрение ноля в математику и его активное использование в различных областях науки.

Таким образом, исторические корни проблемы связаны с разными представлениями и интерпретациями нуля, которые стало возможным преодолеть только после внедрения его в математику в качестве самостоятельного числа.

Роли нуля в математике

Нейтральный элемент сложения: Ноль является нейтральным элементом в алгебраической операции сложения. Это означает, что при сложении любого числа с нулем, результат будет равен этому числу. Например, 5 + 0 = 5. Ноль также является нейтральным элементом для вычитания: 5 - 0 = 5.

Нейтральный элемент умножения: Также ноль является нейтральным элементом в операции умножения. Когда число умножается на ноль, результат всегда будет нулем. Например, 5 * 0 = 0. Эта особенность умножения на ноль имеет важные последствия в различных областях, таких как алгебра и анализ.

Деление на ноль: В математике разделение на ноль считается недопустимой операцией, так как это приводит к неопределенности и противоречиям. Попытка разделить одно число на ноль не имеет смысла и не имеет определенного результата. Это состояние известно как "деление на ноль".

Представление нуля: Ноль также занимает важное место в позиционной системе и в методах представления чисел. Например, система десятичных чисел использует ноль для представления отсутствия разряда в определенном месте числа. Это позволяет представлять числа любой величины и точности, используя всего десять символов.

Границы и множества: Ноль играет интригующую роль в анализе и геометрии. Например, понятий предела и непрерывности невозможно понять без учета нуля. Множество действительных чисел и их отрицательных значения были значительно расширены с появлением нуля.

Таким образом, ноль играет ключевую роль в математике, определяя операции и концепции, а также предоставляя мощный инструмент для анализа и представления чисел.

Причины множества нулей в математике

Одной из основных причин существования такого множества нулей в математике является его роль в арифметических операциях. Например, при сложении нуля с любым числом, результатом всегда будет это самое число. Это свойство нуля позволяет нам получать различные комбинации чисел, а также проводить различные алгебраические манипуляции.

Другая причина множества нулей заключается в его связи с понятием равенства. Ноль является нейтральным элементом в отношении сложения и умножения, что означает, что он не меняет значения других чисел при выполнении этих операций. Ноль также является уникальным, поскольку не приводит к изменениям при операции умножения.

Ноль также играет важную роль в различных областях математики, включая математическую логику, геометрию и теорию вероятностей. Он может быть использован для формализации различных концепций и понятий и является базовой основой для построения других чисел и структур.

Таким образом, множество нулей в математике объясняется его уникальными свойствами и ролями в различных аспектах математической науки. Ноль выступает как основной элемент в арифметических операциях и равенствах, а также имеет значимое значение в других областях математики.