Определение тональности текста является важным компонентом анализа сентимента и реакции общественности на различные события, товары или услуги. В современном обществе мнения людей активно выражаются в социальных сетях, блогах и новостных статьях. Автоматическое определение тональности позволяет быстро обработать большие объемы текста и извлечь ценную информацию.

Python является одним из самых популярных языков программирования для обработки естественного языка (NLP). В нем существуют различные методы и инструменты для определения тональности текста. Они основаны на использовании различных алгоритмов машинного обучения, статистики и лингвистики.

Одним из подходов к определению тональности является использование словарей со словами, каждому из которых присвоена определенная тональность. Такой подход используется в алгоритмах, которые сравнивают количество и тональность позитивных и негативных слов в тексте. Другой подход основан на машинном обучении, где используются классификационные алгоритмы и модели, обученные на размеченных данных. Также существуют гибридные методы, которые комбинируют различные подходы для достижения более точных результатов.

Методы и инструменты для определения тональности в Python

Один из самых популярных методов для определения тональности текста - это машинное обучение на основе моделей классификации. В Python можно использовать различные библиотеки, такие как scikit-learn или NLTK, которые предоставляют готовые модели и алгоритмы классификации для работы с текстовыми данными.

Другим способом определения тональности текста в Python является использование словарей с эмоциональными окрасками слов. Например, в библиотеке nltk.sentiment есть готовый словарь EmoLex, который содержит информацию о семантическом окраске слов. С помощью этого словаря можно оценивать тональность текста, подсчитывая количество положительных и отрицательных слов в нем.

Также существуют специализированные инструменты для определения тональности текста в Python. Например, библиотека TextBlob предоставляет простой интерфейс для работы с анализом тональности. Она использует базовые методы машинного обучения и словарные подходы для определения эмоционального окраса текста.

Машинное обучение

Машинное обучение позволяет решать разнообразные задачи, такие как классификация, регрессия, кластеризация и обнаружение аномалий. Эти задачи решаются с помощью построения математических моделей, которые предсказывают взаимосвязь между данными и выходными значениями или классами. Модели обучаются на тренировочных данных, чтобы после этого можно было делать предсказания на новых данных.

Для реализации машинного обучения в Python существует множество библиотек и инструментов, таких как scikit-learn, TensorFlow, Keras, PyTorch и другие. Они предоставляют готовые реализации алгоритмов и моделей, а также упрощают работу с данными, предобработкой и визуализацией.

Машинное обучение активно применяется во многих областях, включая финансы, медицину, автопром, рекламу и многие другие. Оно применяется для прогнозирования и оптимизации процессов, улучшения качества продуктов и услуг, автоматизации рутинных задач и принятия решений на основе данных.

Основные методы машинного обучения включают в себя:

- Обучение с учителем, где модель обучается на данных с известными ответами (метками).

- Обучение без учителя, где модель изучает внутреннюю структуру данных и находит закономерности без помощи меток.

- Обучение с подкреплением, где модель обучается на основе опыта и получает обратную связь в виде вознаграждения или наказания.

Благодаря машинному обучению, компьютеры способны выполнять задачи, которые раньше считались прерогативой человека. Оно является одной из ключевых технологий будущего и продолжает активно развиваться.

Анализ чувствительности

Для проведения анализа чувствительности в Python существует несколько методов и инструментов. Один из таких инструментов - библиотека Scikit-learn. Она позволяет применить различные модели машинного обучения для определения тональности текста и провести анализ чувствительности.

Важным шагом в анализе чувствительности является выбор входных параметров, которые будут изменяться. Например, это может быть выбор набора признаков для обучения модели или изменение гиперпараметров модели. После выбора параметров производится анализ и оценка изменений в результатах.

Анализ чувствительности является важным инструментом для понимания, какие факторы влияют на результаты анализа тональности текста и насколько сильно. Это позволяет улучшить модель и повысить точность определения тональности.

Важно отметить, что анализ чувствительности необходимо проводить внимательно, с учетом специфики задачи и данных. Изменение определенных параметров может привести к нежелательным результатам или искажению информации.

Семантический анализ

В основе семантического анализа лежит использование лингвистических и статистических методов. Он подразумевает анализ текста на основе его лексических, грамматических и синтаксических характеристик. Данный подход позволяет определить не только тональность текста, но и выявить дополнительные аспекты, такие как субъективность, эмоциональность или настроение автора.

Семантический анализ может быть осуществлен с использованием различных алгоритмов машинного обучения, которые обрабатывают текст и выделяют его смысловую информацию. Некоторые из таких алгоритмов включают в себя классификацию, регрессию, кластеризацию, деревья решений и нейронные сети. Уникальность и эффективность каждого из алгоритмов зависит от конкретной задачи и типа данных.

- В настоящее время существует множество инструментов и библиотек, которые позволяют проводить семантический анализ текста. Некоторые из таких инструментов включают в себя Natural Language Toolkit (NLTK), TextBlob, VaderSentiment, spaCy и многие другие. Эти инструменты обеспечивают высокую точность и скорость обработки текста, что позволяет проводить семантический анализ в реальном времени.

- Семантический анализ находит широкое применение во многих сферах, включая социальные медиа, маркетинг, финансы, медицину, публичные отношения и т.д. Он позволяет автоматически анализировать большие объемы текста и выявлять важную информацию, которая может быть использована для принятия решений и разработки стратегий.

Использование словарей

Создание словаря в Python выглядит следующим образом:

dictionary = {

"word_1": "positive",

"word_2": "negative",

"word_3": "neutral"

}

В данном примере, слово "word_1" имеет положительную тональность, "word_2" - отрицательную, а "word_3" - нейтральную.

После создания словаря, можно использовать его для определения тональности текста. Необходимо разбить текст на отдельные слова и проверить каждое из них наличием в словаре:

text = "Этот фильм был очень хорошим и интересным"

words = text.split()

for word in words:

if word in dictionary:

print(f"Слово '{word}' имеет тональность '{dictionary[word]}'")

Слово 'хорошим' имеет тональность 'positive'

Слово 'интересным' имеет тональность 'positive'

Использование словарей позволяет легко определять тональность текста на основе заранее определенных значений. Кроме того, словари могут быть дополнены или изменены в процессе работы программы, что делает их гибким и удобным инструментом для анализа тональности.

Нейронные сети

Существует несколько различных архитектур нейронных сетей, используемых для определения тональности текста. Некоторые из них включают рекуррентные нейронные сети (RNN), сверточные нейронные сети (CNN) и комбинированные архитектуры.

Нейронные сети позволяют создавать мощные и гибкие модели, способные обрабатывать большие объемы данных и распознавать тонкие паттерны в тексте. Это делает их одним из наиболее эффективных инструментов для определения тональности текста в Python.

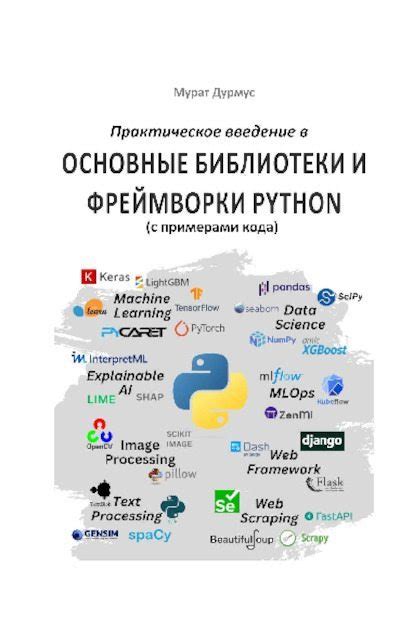

Библиотеки и фреймворки Python

Python имеет широкий спектр библиотек и фреймворков для разработки приложений различных типов. Эти инструменты могут значительно упростить и ускорить процесс разработки, облегчить рутинные задачи и повысить эффективность работы.

Среди самых популярных библиотек языка Python для обработки текста и определения тональности можно выделить:

- NLTK (Natural Language Toolkit) - один из старейших и наиболее популярных инструментов для обработки естественного языка. NLTK предоставляет широкий набор функций для анализа текста, включая методы для токенизации, лемматизации, стемминга, определения тональности и многое другое.

- TextBlob - простая и удобная библиотека для работы с текстом, основанная на NLTK. TextBlob предоставляет простой интерфейс для различных задач, включая определение тональности текста.

- VADER (Valence Aware Dictionary and sEntiment Reasoner) - библиотека, специально разработанная для определения тональности текста в социальных сетях и других источниках с неформальным языком. VADER использует словарь с оценками тональности слов и специальные правила для получения совокупной оценки тональности текста.

Кроме библиотек, в Python также есть мощные фреймворки для обработки текста и анализа тональности:

- SpaCy - фреймворк для обработки и анализа текста высокой производительности. SpaCy предоставляет различные функции для токенизации, лемматизации, синтаксического анализа и определения сущностей в тексте.

- Flair - библиотека и фреймворк для обработки текста, основанные на нейросетевых моделях. Flair предоставляет мощный инструментарий для обучения и использования моделей глубокого обучения для различных задач, включая определение тональности.

Эти библиотеки и фреймворки являются только небольшой частью широкого выбора инструментов, доступных в Python для обработки текста и определения тональности. Выбор подходящего инструмента зависит от конкретных требований и задач проекта.

Примеры приложений для определения тональности

Определение тональности текста может быть использовано в различных приложениях для анализа и классификации текстовых данных. Ниже приведены несколько примеров таких приложений:

1. Социальный мониторинг. Определение тональности позволяет анализировать отзывы, комментарии и сообщения пользователей в социальных сетях. На основе этого анализа можно выявлять настроения и мнения пользователей относительно определенного продукта, бренда или события.

2. Финансовый анализ. Определение тональности может помочь в финансовых аналитических системах. Например, при анализе новостных статей и отчетов можно определить, как негативно или позитивно рынок отреагировал на определенное событие или новость.

3. Маркетинговый анализ. Определение тональности может быть использовано для анализа отзывов клиентов о продукте или услуге. Это помогает компаниям понять, как воспринимают их продукт или бренд, и принимать соответствующие маркетинговые решения.

4. Политический анализ. Определение тональности позволяет анализировать политические выступления, интервью и другие текстовые материалы, связанные с политикой. Это может помочь понять, какие мнения и настроения преобладают в обществе относительно определенных политических событий и фигур.

Использование методов и инструментов для определения тональности текста может значительно облегчить анализ больших объемов текстовых данных и помочь принимать информированные решения в различных областях деятельности.