Apache Spark – это высокопроизводительная платформа обработки больших данных, разработанная в компании Apache Software Foundation. Она предоставляет удобный и эффективный способ работы с данными, позволяя выполнять операции над ними на очень высокой скорости.

Одним из основных принципов работы Spark является ин-мемори вычисление, то есть хранение данных в оперативной памяти. Это позволяет значительно сократить время выполнения операций, так как обращение к данным происходит значительно быстрее, чем при использовании дискового хранения.

Spark предоставляет широкий набор модулей и библиотек, которые позволяют выполнять различные операции с данными, такие как загрузка, трансформация, агрегация и анализ. Кроме того, она поддерживает работу с большим количеством источников данных, включая файловые системы, базы данных, сервисы облачных хранилищ и другие.

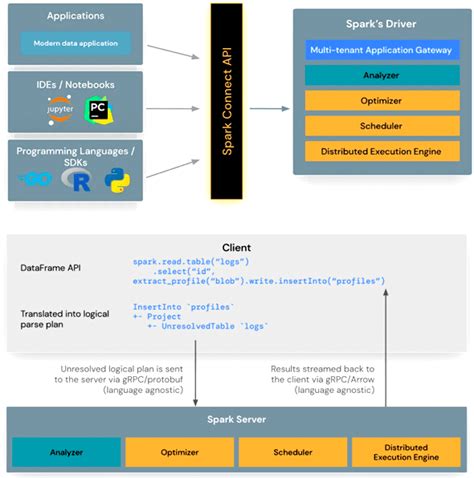

Приложение Spark предоставляет удобный интерфейс для взаимодействия с платформой и использования ее возможностей. Оно позволяет разработчикам писать и запускать программы на языках программирования, таких как Java, Scala, Python и R, а также взаимодействовать с данными и выполнять операции над ними с помощью API Spark.

Основные принципы работы приложения Spark

Apache Spark, одна из самых популярных распределенных вычислительных систем, предоставляет мощные возможности для обработки больших объемов данных. В основе работы Spark лежат несколько ключевых принципов, которые обеспечивают высокую производительность и эффективность в работе с данными.

- Распределенная обработка данных: Spark разбивает данные на множество мелких задач и выполняет их параллельно на большом числе вычислительных узлов. Это позволяет существенно ускорить обработку данных и обеспечить отказоустойчивость системы.

- В памяти обработка данных: Spark активно использует оперативную память для кэширования промежуточных результатов вычислений. Благодаря этому, Spark значительно ускоряет доступ к данным, снижая необходимость в чтении и записи на диск.

- Поддержка различных языков программирования: Spark предоставляет API для работы на различных языках программирования, включая Scala, Java, Python и R. Это позволяет разработчикам использовать предпочитаемый язык и интегрировать Spark с существующими приложениями.

- Модульность и возможность интеграции: Spark построен на модульной архитектуре, что позволяет использовать его в разных контекстах и интегрировать с другими технологиями. Например, Spark может работать с базами данных, файловыми системами и облачными сервисами.

- Распределенные вычисления в парадигме "Resilient Distributed Datasets" (RDD): Spark основывается на концепции RDD, которая позволяет разработчикам выполнять вычисления над данными, хранящимися в оперативной памяти или на диске. RDD предоставляет удобный API для манипуляции данными и поддержку разных видов операций (например, фильтрация, отображение, агрегация).

Приложение Spark сочетает в себе высокую производительность, гибкость и легкость в использовании, позволяя разработчикам эффективно работать с большими объемами данных и справляться с сложными вычислительными задачами.

Понятие и назначение

Основное назначение Spark - обработка и анализ больших объемов данных. Он предлагает удобный и мощный API для распределенных вычислений, позволяющий эффективно работать с данными в памяти. Благодаря своим возможностям, Spark может обрабатывать терабайты данных на кластерах из сотен и тысяч узлов.

Spark включает в себя модули для работы с различными типами данных и источниками данных, такими как структурированные данные, нереляционные данные, файлы в формате Parquet, Apache Kafka, Apache Hadoop и многими другими. Он также предоставляет интеграцию с другими платформами и инструментами, такими как Hadoop, Hive, HBase и R.

Основные возможности

Масштабируемость Spark обладает высокой масштабируемостью и может эффективно обрабатывать данные, распределенные по нескольким компьютерам или серверам. | Высокая скорость обработки Благодаря своей архитектуре и оптимизациям, Spark может обрабатывать данные с высокой скоростью, что позволяет сократить время выполнения анализа и обработки данных. |

Поддержка различных источников данных Spark поддерживает работу с разнообразными источниками данных, включая файлы в различных форматах (например, CSV, JSON, Parquet), базы данных (например, Hadoop, Cassandra) и стриминговые источники (например, Kafka, Flume). | Большой набор библиотек и инструментов Spark предоставляет набор инструментов и библиотек для решения различных задач обработки данных, включая машинное обучение (MLlib), графовые вычисления (GraphX) и обработку стримов данных (Structured Streaming). |

Поддержка различных языков программирования Spark поддерживает программирование на Java, Scala, Python и R, что позволяет разработчикам выбирать наиболее удобный язык для решения своих задач. | Интерактивная аналитика Spark предоставляет средства для выполнения интерактивной аналитики, что позволяет быстро исследовать данные, проводить эксперименты и получать результаты на ходу. |

Архитектура и компоненты

Главными компонентами архитектуры Spark являются:

1. Драйвер

Драйвер - это основной компонент Spark, который запускается на главном узле кластера и управляет выполнением всего приложения. Драйвер задает инструкции для выполнения различных операций и планирует задачи на различных узлах кластера.

2. Кластер менеджер

Кластер менеджер - это программа, отвечающая за управление ресурсами кластера и планирование задач на узлах. Spark поддерживает различные кластерные менеджеры, такие как Apache Mesos, Hadoop YARN и Standalone. Кластер менеджер обеспечивает эффективное использование ресурсов кластера и балансировку нагрузки.

3. Рабочие узлы

Рабочие узлы - это физические или виртуальные машины, на которых выполняются вычисления. Рабочие узлы получают инструкции от драйвера и обрабатывают данные параллельно. Каждый узел имеет свои вычислительные ресурсы и хранит свою часть данных.

4. Распределенное хранилище данных

Распределенное хранилище данных - это хранилище, в котором Spark хранит данные перед их обработкой. Оно обеспечивает устойчивость данных и доступ к ним из различных узлов кластера. Spark поддерживает различные распределенные хранилища данных, такие как Hadoop Distributed File System (HDFS), Amazon S3 и Apache Cassandra.

Все эти компоненты взаимодействуют между собой для выполнения задач Spark. Драйвер отправляет инструкции рабочим узлам через кластерный менеджер, которые обрабатывают данные и возвращают результаты обратно драйверу. Этот процесс происходит параллельно и динамически масштабируется в зависимости от объема данных и вычислительной мощности кластера.

Основные принципы работы

Работа Spark основана на принципе резилентности, который обеспечивает отказоустойчивость данных. Когда данные загружаются в Spark, они делятся на небольшие блоки и дублируются на разных узлах кластера. Если какой-либо узел выходит из строя, Spark может восстановить данные с помощью дублированных копий на других узлах.

Spark предлагает высокоуровневые API на разных языках, включая Scala, Java, Python и R. Все операции в Spark построены вокруг концепции набора данных (dataset), который является неизменяемым и параллелизируемым. Набор данных в Spark - это отказоустойчивая коллекция объектов, которая может быть распределена по нескольким узлам кластера.

Принципы работы Spark также включают в себя ленивость вычислений - операции над набором данных выполняются только при необходимости. Spark строит логический граф операций, но на самом деле он начинает выполнять вычисления только при вызове действий (action). Это позволяет оптимизировать производительность и ускорить обработку данных.

Для эффективной работы с данными в памяти, Spark использует технику инмемори-компьютинга. Он может кэшировать промежуточные результаты вычислений на уровне операций или наборов данных, чтобы избежать повторных чтений с диска. Это позволяет снизить задержки во время обработки данных и увеличить скорость вычислений.

Основные принципы работы Spark - это группировка операций в трансформации и вызов действий для их выполнения. Spark поддерживает различные операции, включая фильтрацию, сортировку, агрегацию, объединение, аналитические функции и многое другое. Он также предлагает библиотеки для машинного обучения, графовых алгоритмов, обработки потоковых данных и распределенной обработки SQL.

| Преимущества | Ограничения |

| Мощные инструменты обработки Big Data | Требует кластер для работы |

| Отказоустойчивость данных | Требует знания концепций распределенных вычислений |

| Высокоуровневые API на разных языках | Может быть сложным для начинающих |

| Ленивость вычислений | Может потребоваться дополнительная конфигурация для оптимизации производительности |

| Инмемори-компьютинг для ускорения обработки данных | Может потребоваться больше ресурсов для работы с большими объемами данных |

| Широкий спектр операций и библиотек | Нет поддержки для реляционных операций напрямую |

Интеграция и совместимость

Apache Spark предоставляет различные возможности для интеграции с другими платформами и инструментами. Он обладает богатыми наборами API для работы со множеством языков программирования, включая Java, Scala, Python и R. Это позволяет разработчикам использовать Spark в своем любимом языке и интегрировать его с существующими приложениями.

Spark может взаимодействовать с самыми популярными системами управления базами данных, такими как Apache Hive, Apache HBase, Apache Cassandra, а также с реляционными базами данных, такими как MySQL и PostgreSQL. Это позволяет использовать Spark в различных сценариях, включая анализ больших объемов данных, обработку стримовых данных и машинное обучение.

Одним из главных преимуществ Spark является его совместимость с другими технологиями в экосистеме Hadoop. Spark может работать на кластерах Hadoop, используя Hadoop Distributed File System (HDFS) для хранения и обработки данных. Он также может взаимодействовать со Spark SQL, который предоставляет возможность выполнения SQL-запросов непосредственно к данным Spark.

Spark умеет работать с Apache Kafka, системой распределенной обработки сообщений, что позволяет писать высокотребовательные к производительности приложения для работы со спорадическими и быстро поступающими сообщениями.

Наличие широкого спектра интеграции и совместимости делает Spark мощным инструментом для разработки приложений обработки больших данных.

Преимущества и применение

1. Высокая скорость обработки данных. Spark использует распределенную архитектуру и встроенную оптимизацию, что позволяет обрабатывать данные гораздо быстрее, чем традиционные инструменты.

2. Наличие различных библиотек и модулей. Spark предлагает большой набор библиотек и модулей для различных целей, таких как машинное обучение, анализ данных, обработка потоковых данных и т. д.

3. Поддержка разных языков программирования. Spark можно использовать с различными языками программирования, включая Java, Scala, Python и R. Это делает приложение Spark доступным для широкого круга разработчиков.

4. Гибкость и масштабируемость. Spark позволяет легко масштабировать приложение при обработке больших объемов данных. Оно также легко интегрируется с другими инструментами и технологиями.

5. Разнообразие применений. Spark может использоваться в различных сферах, включая анализ данных, обработку потоковых данных, биг-дата аналитику, машинное обучение и многое другое. Он подходит как для академических исследований, так и для коммерческого использования.

Учитывая все эти преимущества, приложение Spark становится все более популярным инструментом в сфере обработки данных. Его гибкость, скорость и возможности анализа делают его идеальным выбором для всех, кто работает с большими объемами данных или интересуется развитием аналитического приложения.