Математика, безусловно, является одной из фундаментальных наук, которая лежит в основе многих других областей знания. Но среди всех ее правил и законов есть одно правило, которое вызывает особый интерес и вопросы: почему нельзя делить на ноль? Ответ на этот вопрос лежит в самых глубинах математической логики и имеет объяснение, которое поможет разобраться в этой казалось бы простой, но философской проблеме.

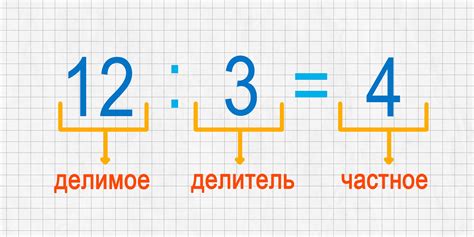

Основополагающим принципом, на котором строится математика и другие науки, является идея о существовании единицы и отсутствии ее разделения на ноль. Деление как операция подразумевает нахождение количества одного объекта в другом. Однако, когда мы задаем вопрос: "Сколько раз можно разделить одну единицу?" и поделим ее на ноль, то работа математической логики оказывается на грани фантастики и нарушает все установленные правила.

Деление на ноль приводит к абсурдным и парадоксальным результатам, которые не имеют логического и смыслового обоснования. Например, рассмотрим выражение 1/0. Если поделить единицу на бесконечно малое число, результат будет стремиться к бесконечности, но при делении одной единицы на саму себя, результат будет равен единице. Таким образом, попытка определить значение деления на ноль приводит к неопределенности и противоречиям, что делает его невозможным.

Проблема деления на ноль: причины и последствия

Основная причина запрета деления на ноль кроется в самой математике. Деление является обратной операцией умножения, и оно основывается на идее распределения одной величины на несколько частей. Однако невозможно равномерно распределить значение на ноль частей, поскольку не существует определенного значения, которое при умножении на ноль даст изначальное значение.

При попытке выполнить операцию деления на ноль в программировании возникает ошибка деления на ноль или сбой программы. Это связано с тем, что компьютеры работают на основе численных операций, и деление на ноль невозможно в рамках числовых вычислений. Результат деления на ноль является неопределенным, и компьютер не может обработать такую ситуацию.

Последствия деления на ноль могут быть разными и зависят от контекста использования. В некоторых случаях после выполнения операции деления на ноль будет получен бесконечность или отрицательная бесконечность. Например, при делении положительного числа на ноль результатом будет положительная бесконечность, а при делении отрицательного числа на ноль - отрицательная бесконечность.

Однако в других случаях может произойти сбой программы или ошибка вычисления. Например, если программа использует результат деления на ноль в качестве делителя для следующей операции, это может привести к непредсказуемым результатам или вызвать ошибку выполнения программы.

В итоге, деление на ноль является недопустимой операцией в математике и программировании. Она противоречит основным принципам и правилам вычислений, а также может привести к непредсказуемым последствиям и ошибкам в программном коде. Поэтому необходимо всегда учитывать и избегать деления на ноль при проектировании и разработке программного обеспечения.

Взаимосвязь с математическими правилами

Причина того, почему на ноль делить нельзя, связана с основными математическими правилами и определениями. Рассмотрим некоторые из них:

Определение дроби:

Дробь представляет собой отношение двух чисел, где числитель и знаменатель являются целыми числами. В случае деления на ноль, знаменатель становится равным нулю, что противоречит данному определению.

Определение деления:

В математике деление – это операция, обратная умножению. Если умножение числа на другое не равно нулю, то и деление этого числа на ненулевое число возможно и имеет единственное значение. Однако, деление на ноль не имеет определенного значения, так как невозможно найти число, при котором произведение его на ноль будет равно какому-либо ненулевому значению.

Определение некоммутативности:

Математическая операция деления не является коммутативной, то есть результат деления на число будет отличаться в зависимости от порядка чисел в операции. Если рассмотреть деление числа на ноль, то второе число, в данном случае ноль, не может быть делителем, так как результатом будет неопределенность.

Определение бесконечности:

Ноль является особой точкой на числовой прямой, так как на него не существует даже предела. При делении числа на ноль результат стремится к бесконечности, что делает его неопределенным и неустойчивым в математических операциях.

Таким образом, все эти математические правила и определения объясняют, почему на ноль делить нельзя. Это вплотную связано с основами алгебры и действий с числами, и позволяет предотвратить возникновение логических ошибок и противоречий в математических расчетах.

Математический аспект: невозможность определения

Когда мы делаем деление, мы ищем число, при умножении которого на ноль получится исходное число. Однако, в случае деления на ноль, нам не удается найти такое число. Это происходит потому, что на самом деле деление на ноль вообще невозможно определить в математике.

Когда мы пытаемся найти решение для уравнения x ÷ 0 = a, где x и a - любые числа, мы сталкиваемся с противоречием. Даже если мы попытаемся предположить, что результат такого деления равен какому-то числу, например, x ÷ 0 = b, то при умножении обратно на ноль получим b × 0 = x. При этом у нас снова возникнет проблема: какое число нужно умножить на ноль, чтобы получить исходное число x? Очевидно, что ответ на этот вопрос не может быть определен, поэтому деление на ноль математически невозможно.

Причина, по которой нельзя делить на ноль, кроется в противоречии, возникающем при попытке определить результат такой операции. Именно из-за отсутствия определенного результата деление на ноль считается некорректным математическим действием.

Практические последствия

На первый взгляд, непоказательно, что деление на ноль может иметь практические последствия. Однако, это явление может привести к серьезным проблемам в различных областях, включая математику, программирование и физику.

В математике деление на ноль считается неопределенностью и может повлиять на результаты вычислений и логических рассуждений. Например, при попытке решить уравнение, содержащее деление на ноль, получается неопределенность, и невозможно определить корректное значение переменной.

В программировании деление на ноль может вызвать ошибки и аварийное завершение программы. Когда программа пытается выполнить операцию деления на ноль, это приводит к исключению, которое может привести к сбою всей программы. Часто программисты обрабатывают эту ошибку, чтобы избежать нежелательных последствий.

Поэтому, практические последствия деления на ноль требуют аккуратности и осторожности при выполнении вычислений и программировании.

Влияние на вычисления и программирование

Понимание того, почему на ноль делить нельзя, играет важную роль в математике, вычислениях и программировании. Нулевое значение имеет особое значение и может приводить к непредсказуемым результатам, которые могут сильно повлиять на работу программного кода.

Во-первых, деление на ноль может привести к ошибкам выполнения программы. Если в программе есть инструкция деления на ноль, то это приведет к сбою программы или остановке выполнения. Подобные ошибки могут быть сложными для отладки и исправления, особенно в больших проектах.

Во-вторых, деление на ноль может привести к неверным результатам вычислений. В математике мы знаем, что делить на ноль невозможно, и результат такого деления неопределен. Однако, в программировании это может привести к появлению особых значений, таких как бесконечность или NaN (Not a Number), которые могут искажать или испортить результаты вычислений.

Также, деление на ноль может стать причиной возникновения ошибок при работе с памятью. В некоторых языках программирования, попытка деления на ноль может привести к выделению памяти нулевой длины или вызвать исключение, что может привести к аварийному завершению программы.

Поэтому, в программировании очень важно проверять значения перед делением и предусматривать возможные ситуации, когда деление на ноль может произойти. Это поможет избежать ошибок выполнения, непредсказуемых результатов и улучшит надежность кода.

Абстрактное понятие и его приложение в разных областях

Абстрактные понятия имеют важное значение в разных областях, включая философию, науку, математику, искусство и инженерию. Они помогают людям понять сложные концепции и развивать новые идеи.

В философии, абстрактные понятия используются для понимания и анализа фундаментальных вопросов о реальности, смысле жизни, моральных ценностях и других философских темах. Они позволяют философам задавать глубокие вопросы и искать ответы на них.

В науке, абстрактные понятия используются для формулирования гипотез, разработки теорий и проведения экспериментов. Например, ученые используют абстрактные понятия, чтобы описать физические явления, включая электромагнитные волны, квантовую механику и гравитацию.

В математике, абстрактные понятия играют важную роль в развитии новых теорий и методов. Например, понятие «множество» является абстрактным понятием, которое используется для описания различных объектов и их связей между собой. Абстрактные понятия также используются в алгебре, геометрии и других разделах математики.

В искусстве, абстрактные понятия помогают художникам выражать свои идеи и эмоции через форму, цвет, текстуру и другие художественные элементы. Абстрактное искусство позволяет зрителям воспринимать произведение искусства через свое воображение и воспоминания, что может вызывать различные эмоции и ассоциации.

В инженерии, абстрактные понятия используются для проектирования и разработки новых технологических решений. Например, инженеры используют абстрактные понятия, чтобы создавать компьютерные программы, архитектурные проекты и механические системы.

Все эти области демонстрируют важность абстрактных понятий в нашей жизни. Они помогают нам понять мир вокруг нас, развивать новые идеи и решать сложные проблемы. Без абстрактных понятий, наш мир был бы лишен глубины и творчества.

Понятие "деление на ноль" в философии и логике

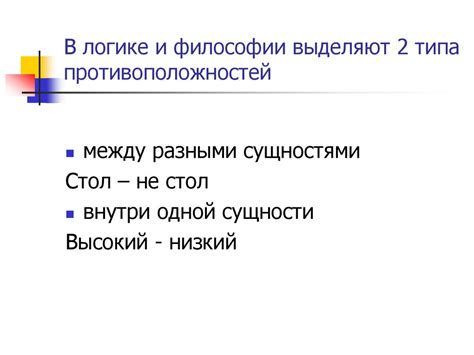

Понятие "деление на ноль" имеет значительное значение не только в математике, но и в философии и логике. В этих областях оно служит уникальным примером иллюстрации проблемы определения и ограничения абсурда.

Согласно логике и философии, "деление на ноль" представляет собой ситуацию, в которой происходит нарушение принятых логических правил и некорректное применение математических операций. В результате возникает парадокс, который выходит за рамки рационального мышления и логики.

Основным аргументом противопоставления "делению на ноль" является его непредсказуемость и невозможность определить его результат. Математический и логический анализ показывают, что деление на ноль приводит к неопределенности и противоречию в рамках известных логических законов и аксиом.

Философия и логика рассматривают "деление на ноль" как пример парадоксальной ситуации, которая вводит сомнения в принципиальную возможность определения абсолютной истины и законов. Данный парадокс напоминает ограничения познания и внутреннюю противоречивость человеческого мышления.

В истории философии было предложено несколько подходов к объяснению и интерпретации "деления на ноль". Некоторые философы считают, что это явление затрагивает самую суть математики и необходимо искать новые методы и правила для его решения. Другие утверждают, что "деление на ноль" служит примером лимитации нашего познания и указывает на ограничения нашего мышления и знания.

Таким образом, понятие "деление на ноль" в философии и логике занимает особое место, позволяя обозначить проблемы абсурда, неопределенности и границ возможного. Оно подчеркивает сложность мира и масштабы наших знаний и оснований для их верности и достоверности.