Если вы когда-либо задавались вопросом, какое число получитесь при делении нуля на ноль, то ответ на этот вопрос не существует. В математике это называется неопределенность. Почему же нельзя разделить 0 на 0?

Разделение любого числа на ноль> приводит к неопределенности, но когда мы говорим о делении нуля на ноль, ситуация становится еще более запутанной. Попробуйте представить, что у вас есть 0 яблок, и вы хотите равномерно разделить их между нулем людей. Сколько яблок получит каждый человек? Математически это невозможно определить.

Математика основана на логических принципах, и деление нуля на ноль логически противоречит этим принципам. В результате все попытки определить результат такого деления приводят к противоречию и несостоятельности.

Почему не стоит делить на ноль?

Деление на ноль в математике считается недопустимым, и данное правило распространяется и на программирование.

Основная причина, по которой нельзя делить на ноль, заключается в том, что математические операции с нулем противоречат основным принципам арифметики. При делении на ноль результат не имеет определения и является неопределенным.

Математическое доказательство этого факта представляется в виде ‘а*b = c’, где ‘a’ и ‘b’ обозначают числа, а ‘c’ обозначает их произведение. Если применим формулу, приравняв ‘c’ к 0 (ноль) и ‘b’ к 0, получим неразрешимую ситуацию.

В программировании деление на ноль может привести к ошибкам и нежелательным последствиям. При попытке разделить любое число на ноль, интерпретатор языка программирования обычно возбудит исключение «деление на ноль» или выдаст ошибку выполнения. Множество сценариев и алгоритмов, таких как вычисления, условия и циклы, могут быть нарушены из-за недопустимого деления на ноль, что может привести к непредсказуемым последствиям.

Поэтому при программировании важно проверять данные на возможность деления на ноль и предусматривать соответствующие действия в случае обнаружения такой ситуации. Математически и технически разделить число на ноль невозможно и потенциально может привести к ошибке, поэтому важно всегда помнить о причинах запрета на деление на ноль и следовать этим правилам при написании программного кода.

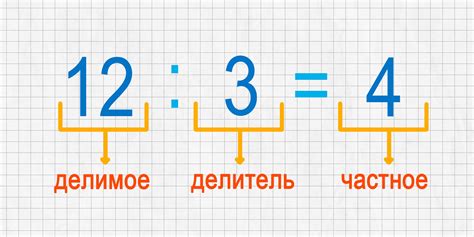

Понятие деления на ноль

Математический смысл деления заключается в том, что необходимо разделить число или значение на определенную единицу, чтобы получить другое число или значение. Например, можно поделить 10 на 2 и получить результат 5.

Однако, деление на ноль не имеет такого смысла. Попытка разделить число на ноль приводит к некорректному и неопределенному результату. Можно сказать, что деление на ноль противоречит логике математики и не имеет смысла в рамках обычной арифметики.

При попытке поделить ноль на ноль оказывается еще более интересная ситуация. Результат такого деления не определен и может принимать любое значение. Например, можно ожидать получить 0 (при условии, что числитель и знаменатель равны), однако, возможны и другие результаты.

Поэтому, деление на ноль считается ошибкой и недопустимым действием в математике. Для избегания путаницы и некорректных результатов, в программировании и вычислениях обычно используется проверка на ноль перед выполнением операции деления.

Ошибки и противоречивость

Деление на ноль приводит к противоречивым результатам и приводит к ошибкам. Звучит логично, поскольку ноль не является числом в обычном смысле, он не имеет определенного значения. Проблема возникает, когда мы пытаемся разделить что-то на ноль.

Результатом такого деления может быть любое число или даже неопределенность. Это просто не имеет смысла и не соответствует основным математическим правилам. Поэтому деление на ноль признается невозможным операцией.

Попытка разделить ноль на ноль особенно противоречива. В этом случае, такое деление можно рассматривать как любое число или как неопределенность, что не имеет единственного правильного ответа. Значение такого деления противоречит самой идее математики.

Поэтому в математике существует специальный термин для выражений, содержащих деление на ноль - "неопределенная форма". Это форма, которая не может быть вычислена, потому что она противоречива и не имеет определенного значения.

Таким образом, деление на ноль не только ведет к ошибкам и противоречивым результатам, но и противоречит самой природе математики. Поэтому мы должны быть осторожны и избегать таких операций, чтобы избежать противоречивости и ошибок в наших математических вычислениях.

Результат деления на ноль

Результат деления на ноль невозможен, поскольку деление определяется как обратная операция умножению, а умножение на ноль не даёт однозначного результата. Например, мы можем умножить ноль на любое число и получить ноль, но не можем разделить число на ноль и получить какой-то определенный результат.

Когда мы пытаемся разделить ноль на ноль, ситуация становится еще более запутанной. Обычно мы ожидаем, что ноль деленный на какое-либо число будет равен нулю, но ноль деленный на ноль не может быть равен нулю, так как ноль умноженный на любое число может быть равен нулю. Поэтому результат деления на ноль неопределен и не имеет смысла.

В мире математики и программирования деление на ноль считается ошибкой, и в разных языках программирования может быть обработано по-разному. Например, в некоторых языках программирования при делении на ноль будет выброшено исключение или возвращено специальное значение, такое как "бесконечность" или "неопределенность".

Деление на ноль в математических операциях

Почему нельзя разделить ноль на ноль? Ответ на этот вопрос прост - деление на ноль не имеет смысла и противоречит математической логике.

Представим ситуацию, когда имеется некоторое количество объектов, обозначаемое числом ноль. Если мы попытаемся поделить эти нулевые объекты на ноль, мы не сможем однозначно определить, сколько объектов будет получено у каждого из них. Ноль делится на несколько равных частей, и это противоречит понятию "деления" в математике.

Более того, если мы рассмотрим случай, когда некоторое число делится на ноль, то также становится непонятным, какое число необходимо умножить на ноль, чтобы получить исходное. Это приводит к неопределенности и противоречию в математических операциях.

Ноль является особенным числом, которое не может быть использовано в качестве делителя или делимого. Подобное правило является одним из основных в математике и позволяет избежать неопределенности и противоречия в вычислениях.

Математическая неопределенность

Основная причина, по которой нельзя разделить ноль на ноль, заключается в том, что нет единственного числа, которое можно было бы получить в результате такой операции. Если мы разделим ноль на любое другое число, то получим ноль как результат, но когда деление происходит на ноль, мы не можем однозначно определить, какое число должно быть в результате.

Математическая неопределенность возникает, когда есть несколько возможных значений для результата, и нельзя определить одно определенное значение. В данном случае, деление на ноль приводит к неоднозначности, так как можно рассчитывать разные значения в зависимости от выбранного контекста или области применения.

Математики исключают деление на ноль из обычных математических операций, чтобы сохранить единообразие и логичность математической системы. Деление на ноль является неопределенной операцией, которая выходит за рамки математической консистентности и приводит к неоднозначности в результатах вычислений.

Важно понимать, что деление на ноль не имеет определенного значения и не может быть выполнено в рамках обычной математики.

Математическая неопределенность, такая как деление на ноль, является одной из важных концепций в математике, которая помогает нам понять границы и ограничения формальных вычислений. Кроме деления на ноль, существуют и другие формы математической неопределенности, которые требуют специального рассмотрения и анализа в контексте конкретных задач или проблем.

Важно отметить, что есть математические области, такие как теория пределов и бесконечно малые, где есть способы обращаться с делением на ноль или получения определенного результата при подходящих условиях и подходах. Однако в обычных арифметических операциях деление на ноль остается неопределенной и недопустимой операцией.

Ноль в математике

Ноль - это число, которое представляет отсутствие какого-либо количества или размера. Оно используется для обозначения пустоты или отсутствия чего-либо. В числовых системах ноль обычно расположен между отрицательными и положительными числами и является точкой отчета, относительно которой можно измерять другие числа.

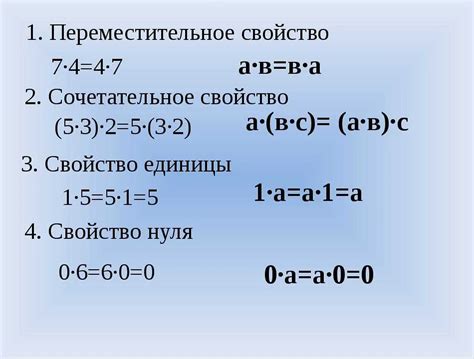

Ноль также широко используется в математических операциях. Например, при сложении ноль с числом оно не изменяется: 0 + a = a и a + 0 = a. Однако когда дело доходит до деления, ноль играет особую роль.

Ноль не может быть использован как делитель, потому что результат деления нуля на любое число или ноль неопределен. Например, попытка разделить ноль на ноль дает неопределенный результат, так как нет определенного числа, при умножении на которое получился бы ноль. Также нельзя разделить ненулевое число на ноль, потому что нет числа, которое при умножении на ноль дало бы ненулевой результат.

В математике существуют различные подходы к работе с нулем и делением на ноль. Например, в арифметике с плавающей запятой деление на ноль может дать в результате бесконечность или специальное значение, такое как NaN (не число).

Следует помнить, что математика строится на принципах логики и четко определенных правилах. Из-за отсутствия четких правил для деления на ноль, результат такой операции неопределен и не может быть однозначно определен.

| Операция | Результат |

|---|---|

| 0 / 0 | Неопределен |

| a / 0 (a ≠ 0) | Неопределен |

Альтернативы делению на ноль

- Представление бесконечности: В некоторых математических системах, таких как расширенные действительные числа или расширенные комплексные числа, можно представить бесконечность. В этом случае деление на ноль может быть заменено на деление на бесконечность.

- Представление неопределенности: В некоторых случаях, особенно в физических и инженерных задачах, деление на ноль может быть связано с неопределенностью результата. Вместо деления на ноль можно использовать некоторую символическую формулу или обозначение, которое указывает на неопределенность.

- Асимптотический подход: В некоторых алгоритмах и моделях использование приближенных значений и асимптотических оценок может помочь избежать прямого деления на ноль. Например, можно использовать очень малое значение вместо нуля или оценить приближенное решение в окрестности точки с нулевым делителем.

Хотя эти альтернативы могут быть полезны в определенных ситуациях, в общем случае следует избегать деления на ноль и стремиться к ясному и корректному математическому описанию операций. Деление на ноль может привести к непредсказуемым результатам и ошибкам в вычислениях.

Применение в научных расчетах

В частности, при использовании числовых методов, таких как численное интегрирование или решение дифференциальных уравнений, деление нуля на ноль может привести к ошибкам вычислений и искажению полученных значений. Это связано с тем, что при делении нуля на ноль не существует определенного числа, которое можно было бы использовать в расчетах.

Поэтому, в научных расчетах строго рекомендуется избегать деления нуля на ноль и заранее проводить необходимые проверки и корректные математические операции для получения достоверных результатов. Это помогает избежать потенциальных ошибок и обеспечить правильное использование численных методов в научных исследованиях.