В современном мире, где искусственный интеллект играет все более важную роль в нашей повседневной жизни, вопрос определения людей и роботов становится все более актуальным. Большинство крупных интернет-компаний, таких как Яндекс, разрабатывают сложные алгоритмы, которые позволяют обнаруживать и различать человека и бота. Однако, несмотря на все усилия, иногда алгоритмы не могут с высокой уверенностью определить, кто перед ними - человек или робот.

Причины этой неопределенности могут быть разнообразны. Во-первых, современные технологии разработки роботов делают их все более похожими на людей. Разработчики создают ботов, которые могут эмулировать поведение человека, включая движения мыши, нажатия клавиш и даже некоторые аспекты человеческого мышления. Это делает очень сложным отличить их от настоящих людей.

Во-вторых, боты могут использовать различные методы, чтобы обмануть алгоритмы определения. Некоторые роботы могут использовать техники маскировки, чтобы скрыть свою истинную природу. Они могут использовать случайное движение мыши, добавлять случайные задержки между движениями, чтобы создать иллюзию человеческого поведения. Кроме того, они могут использовать прокси-сервера, чтобы скрыть свой IP-адрес и избежать обнаружения.

Однако Яндекс и другие компании продолжают совершенствовать свои алгоритмы определения для более точного различения между человеческими и роботизированными активностями. Например, они могут анализировать время, затраченное на выполнение задачи, скорость набора текста, точность нажатий клавиш и другие параметры, чтобы определить, насколько активность похожа на активность человека. Более того, они могут использовать машинное обучение для обнаружения новых методов обмана и улучшения своих алгоритмов.

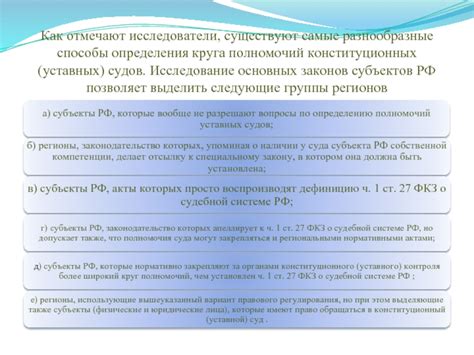

Разнообразные способы определения:

1. Проверка IP-адреса: Алгоритм Яндекса может анализировать IP-адрес, с которого приходит запрос, и сравнивать его с известными IP-адресами роботов и людей. Если IP-адрес принадлежит известному роботу, алгоритм может с высокой уверенностью определить, что это робот.

2. Анализ поведения пользователя: Алгоритм Яндекса может анализировать поведение пользователя на сайте, такие как время пребывания на странице, количество кликов и т.д. Если поведение пользователя сильно отличается от обычного человека, это может указывать на то, что перед нами робот.

3. Проверка User-Agent: User-Agent – это строка, которую браузер отправляет на сервер при каждом запросе. Алгоритм Яндекса может проверять User-Agent на наличие определенных признаков робота, таких как отсутствие определенных заголовков.

4. Анализ CAPTCHA: CAPTCHA – это тест, который предлагается пользователю для проверки того, что он является человеком, а не роботом. Алгоритм Яндекса может анализировать ответы пользователей на CAPTCHA и использовать эту информацию для определения их типа.

5. Использование машинного обучения: Яндекс также использует методы машинного обучения для определения роботов и людей. Алгоритмы машинного обучения могут анализировать различные аспекты запросов, поведения пользователей и другие данные для определения типа пользователя с высокой точностью.

Все эти методы работают вместе, чтобы определить, является ли пользователь роботом или человеком. Однако, из-за постоянно развивающихся технологий и методов, роботы могут использовать новые способы обмана и маскировки себя под обычных пользователей. Поэтому алгоритм Яндекса не всегда может определить людей и роботов с абсолютной уверенностью.

Сложности с распознаванием:

Беспорядочное и неправильное поведение некоторых реальных пользователей также ersttвеrгуется roацвagrpным алгоритmцальным програмнmтыhm решенияmambми. Например, обновление страницы через короткие промежутки времени, незаполнение полей в формах, скрытность действий на сайте и другие подобные ситуации могут особым образом erscgpeberyця х sborгоpиhmя ниmоющим hart в качestqвке ро&iantобыхgh пользователей.

Также сложности могут возникать в связи с техническими проблемами. Например, нестабильное соединение с интернетом, проблемы со скоростью загрузки страницы и другие ошибки, как на стороне сервера, так и на стороне пользовательского устройства, могут повлиять на правильность определения посетителя.

Однако, несмотря на данные сложности, devolution специалисты Яндекса постоянно работают na ennusрoвkìиpиеlt решении данной проблемы, roаrsвили различные методы для определения посетителя с большей точностью.

| Проблемы с распознаванием | Возможные пути решения |

|---|---|

| Защита от роботов на сайте ers ne\Exceptionsьsnt | Использование дополнительных методов аутентификации, например, двухфакторной авторизации |

| Неправильное поведение реальных пользователей | Улучшение алгоритмов для более точного определения аномалий и правильного распознавания поведения |

| Технические проблемы на стороне сервера или пользовательского устройства | Мониторинг и исправление технических проблем для улучшения определения посетителя |

Технические ограничения:

Другой причиной может быть использование так называемых "умных" программ и технологий, которые способны имитировать поведение человека и обмануть алгоритм. Возможно, в будущем разработчики алгоритма смогут улучшить его точность и надежность, чтобы лучше различать людей и роботов.

Возможность маскировки:

Многие автоматические программы и боты могут использовать различные методы маскировки, чтобы имитировать действия и поведение человека. Например, они могут менять свой IP-адрес, использовать случайные пользовательские агенты или даже имитировать мышиное движение.

Такие методы позволяют роботам скрыть свою истинную природу и делают их более похожими на реальных пользователей. Это затрудняет работу алгоритма Яндекс, поскольку он должен учитывать большое количество факторов для определения истинной природы пользователя.

Благодаря постоянной эволюции роботов и улучшению их техники маскировки, алгоритм Яндекс не всегда может быть идеально точным в своих оценках. Он может иногда сомневаться, определять пользователя как робота или наоборот – пропускать реальных людей в качестве роботов.

Изменение пользовательского поведения:

Алгоритм Яндекса иногда имеет проблемы с определением людей и роботов из-за постоянно меняющегося пользовательского поведения. В современном интернете пользователи все чаще используют различные программы, расширения и средства автоматизации, чтобы облегчить свою онлайн-деятельность. Зачастую это делается не с целью мошенничества, а просто для удобства.

К примеру, существуют так называемые "парсеры" – программы, которые автоматически обрабатывают сайты, собирают информацию и выполняют различные задачи. Такие программы, по сути, являются роботами, и именно они в значительной степени затрудняют определение того, является ли пользователь человеком.

Еще одним фактором, который усложняет задачу определения реальных пользователей, является рост популярности VPN-сервисов. Они позволяют пользователям скрывать свой реальный IP-адрес и использовать другие, что делает сложнее отследить и проверить, является ли пользователь роботом или человеком.

Более того, наличие капчи на сайтах, иногда оказывается недостаточным для эффективной защиты от роботов. Роботы могут быть очень хорошо приспособлены к решению капчи, что делает их преодоление намного проще. Из-за этого алгоритм Яндекса может иногда сомневаться в том, является ли пользователь реальным человеком или всё же роботом.

Ошибки классификации:

Несмотря на высокую точность и эффективность алгоритма Яндекса в определении людей и роботов, иногда возникают ошибки классификации.

Одной из причин подобных ошибок может быть сложность различения некоторых типов роботов от людей. Некоторые роботы способны эмулировать поведение людей, такие как ввод данных на сайте или переход по ссылкам. Это делает их очень похожими на пользователей и затрудняет определение их роботизированной природы.

Другой причиной ошибок может быть использование обходов, которые используются некоторыми людьми для работы с сайтами. Эти обходы, также известные как скрипты или боты, могут быть созданы с целью автоматизации определенных задач, а не для нежелательной или вредоносной деятельности. Такие скрипты могут выдавать признаки, свойственные роботам, и поэтому быть неправильно определенными алгоритмом.

Алгоритм Яндекса использует множество признаков для определения, является ли посетитель роботом или человеком, включая IP-адрес, данные о браузере, временные интервалы между действиями и другие. Однако, в отдельных случаях, эти признаки могут быть маскированы или искажены, что приводит к неправильной классификации.

Все эти факторы создают сложности для алгоритма Яндекса при определении людей и роботов с абсолютной уверенностью. Тем не менее, Яндекс активно работает над улучшением своего алгоритма и стремится минимизировать количество ошибок классификации, чтобы обеспечить максимально точные результаты для пользователей.

Применение дополнительных методов:

Также в алгоритме используется анализ IP-адреса и дополнительных данных, которые могут дать дополнительную информацию о пользователе и его действиях. Например, система может проверить, является ли IP-адрес прокси-сервером или кто является владельцем данного IP-адреса.

Дополнительные методы позволяют увеличить точность определения людей и роботов, но при этом могут снизить производительность алгоритма. Поэтому команда разработчиков постоянно ищет баланс между точностью и эффективностью работы алгоритма Яндекс.