В мире компьютерных технологий существует много специальных терминов и технических понятий, которые иногда непросто понять. Один из таких терминов - байт. Байт используется для измерения информации и является основной единицей измерения во многих аспектах компьютерной науки. Но почему именно байт составляет 8 бит?

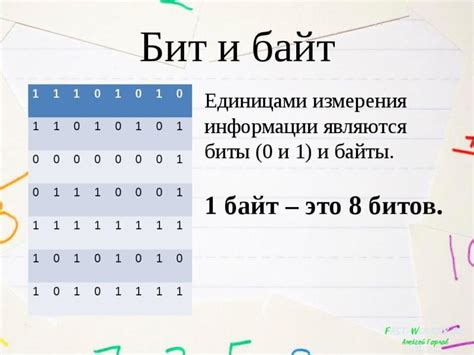

Для ответа на этот вопрос нужно знать, что такое бит. Бит - это самая маленькая единица информации. Он может принимать два значения: 0 или 1. Все данные в компьютере хранятся и обрабатываются в виде битов. Исходя из этого, может показаться логичным, что байт должен быть равен одному биту. Но на самом деле это не так.

Один байт состоит из 8 бит, и это количество было выбрано исторически. В основе такого выбора лежит старая система кодирования, известная как ASCII (American Standard Code for Information Interchange), которая была введена в 1960-х годах. В то время 8 бит было достаточным для представления всех основных символов английского алфавита, цифр и специальных символов.

С течением времени количество символов и языков, которые компьютер должен был поддерживать, увеличилось. Это привело к разработке новых систем кодирования, таких как Unicode, которые используют больше одного байта для представления символов. Однако, несмотря на это, 8 бит по-прежнему используется как основная единица измерения информации, и это объясняется историческими причинами и широким распространением совместимых систем.

Причина, по которой один байт равен 8 бит

Почему же один байт равен 8 битам? Это решение оказалось оптимальным и связано с историческим развитием технологий.

В самом начале развития компьютерных систем было принято использовать двоичную систему счисления для представления информации. Двоичная система счисления основана на двух числах - 0 и 1, которые называются битами (от английского binary digit). Бит - это наименьшая единица информации, которую можно представить в компьютере.

В первых компьютерах целые числа представлялись в виде последовательности битов - единиц и нулей. Однако, с развитием технологий, возникла необходимость представлять более сложные объекты и данные: символы, текст, звук, изображения и т.д. Для этого потребовалась новая единица измерения - байт.

Байт - это последовательность из 8 битов. Использование байта позволило значительно расширить возможности представления информации в компьютерах. Один байт может кодировать 256 различных значений (от 0 до 255) и представлять большое количество символов, чисел и других данных.

Таким образом, один байт равен 8 битам, потому что это оптимальное решение, обеспечивающее эффективное представление информации в компьютерных системах.

Исторические причины формирования стандарта

Стандарт, согласно которому один байт равен 8 битам, был сформирован в результате развития истории компьютерных технологий. В начале появления компьютеров, информация хранилась и передавалась в виде электрических сигналов, которые могли принимать два состояния: включено или выключено. Эти два состояния могли быть представлены с помощью двух битов, то есть двоичных единиц информации.

Однако с развитием вычислительной техники стало ясно, что для операций с большими объемами данных необходимо использовать более высокие степени двоичного числа.

Таким образом, было решено увеличить количество битов, выделяемых для представления информации. Один из первых стандартов, в котором использовалось понятие "байта", был разработан в 1950-х годах для использования в компьютере IBM 700/7000. Поначалу "байтом" считалась последовательность из 6 битов, однако позднее было принято решение увеличить его размер до 8 битов.

Такой выбор был обоснован как техническими, так и практическими соображениями. Увеличение размера байта до 8 битов позволило значительно расширить диапазон значений, которые можно представить внутри одного байта. Это позволило значительно упростить и ускорить обработку информации в компьютерах.

С течением времени стандарт, в котором один байт равен 8 битам, стал широко использоваться в компьютерной технике. Он стал основой для разработки многих протоколов передачи данных, а также систем счисления, используемых в компьютерах.

Связь с основными системами счисления

Один байт равен 8 битам, а это имеет глубокую связь с основными системами счисления: двоичной, восьмеричной и шестнадцатеричной.

В двоичной системе счисления, каждый бит может принимать значения 0 или 1. Отсюда следует, что в одном байте может быть записано 2^8 различных комбинаций, то есть 256 различных значений.

В восьмеричной системе счисления, используются символы от 0 до 7. Поскольку в одном байте есть 8 бит, можно закодировать каждый байт в виде трех восьмеричных цифр. Таким образом, в одном байте может быть записано значения от 000 до 777 (256 в восьмеричной системе).

В шестнадцатеричной системе счисления, используются цифры от 0 до 9 и буквы от A до F. В одном байте можно закодировать две шестнадцатеричные цифры. Таким образом, в одном байте может быть записано значения от 00 до FF (256 в шестнадцатеричной системе).

Связь с основными системами счисления позволяет нам использовать байт как универсальную единицу измерения информации, которая легко конвертируется в другие системы счисления и обеспечивает эффективный способ хранения и передачи данных.

Причина, лежащая в особенностях аппаратной реализации

В основе компьютеров лежат электронные схемы, осуществляющие обработку информации. Схемы представляют собой сети транзисторов, которые могут принимать два состояния: включено (1) и выключено (0). Компьютеры кодируют информацию с помощью этих двух состояний.

Восьмеричная система счисления наиболее эффективна для электронных схем, так как каждый транзистор может представлять одну из восьми комбинаций битов (000, 001, 010, и т.д.). В результате использования восьмеричной системы счисления можно увеличить скорость передачи данных и уменьшить количество необходимых транзисторов.

Компьютеры также представляют информацию в виде двоичных чисел. Из-за простоты и надежности работы с двоичными значениями, компьютеры используют восьмеричную систему счисления для удобства обработки информации.

| Восьмеричная система счисления | Двоичная система счисления |

|---|---|

| 1 | 000 |

| 2 | 001 |

| 3 | 010 |

| 4 | 011 |

| 5 | 100 |

| 6 | 101 |

| 7 | 110 |

| 10 | 111 |

Таким образом, один байт, состоящий из 8 битов, является стандартом для представления информации в компьютерных системах и связан с аппаратной реализацией компьютеров.

Влияние на современные технологии и передачу данных

Размер одного байта, равного 8 битам, имеет существенное влияние на развитие современных технологий и эффективную передачу данных.

Во-вторых, размер байта имеет важное значение при передаче данных по сети. Пакеты данных в компьютерных сетях отправляются и принимаются в виде байтов. За счет единого размера байта, передача информации по сети становится более эффективной и удобной.

Также, единый размер байта обеспечивает совместимость между различными устройствами. Благодаря этому, данные, хранящиеся на одном устройстве, могут быть легко считаны и обработаны другим устройством, что является важным фактором для современной технологии.

Таким образом, размер одного байта, равного 8 битам, играет ключевую роль в современных технологиях, обеспечивая высокую точность обработки данных, эффективную передачу информации и совместимость между устройствами.