Искусственный интеллект набирает все большую популярность в нашем мире. Одним из наиболее впечатляющих достижений в области искусственного интеллекта является GPT (Generative Pre-trained Transformer) – нейросеть с открытым кодом, разработанная OpenAI. GPT способна генерировать тексты любой сложности и создавать фактически неразличимые от настоящих статьи, ответы на вопросы и даже поэзию. Организация OpenAI смело утверждает, что GPT – одна из самых удивительных моделей искусственного интеллекта, созданных человеком.

Принцип работы GPT основан на применении механизма трансформера, который впервые был представлен в 2017 году командой исследователей Google Brain. Трансформер – это модель архитектуры нейронной сети, идея которой заключается в представлении текста в виде последовательности символов или слов, а также в использовании самообучающейся модели, которая анализирует контекст и генерирует соответствующий текст. В отличие от ранее использовавшихся рекуррентных нейронных сетей (RNN), трансформер позволяет анализировать не только контекст, но и дальнейшие слова или символы, что значительно улучшает качество результатов генерации.

Основной алгоритм работы GPT состоит из двух этапов: преподготовка модели и дообучение с применением обратной связи. На первом этапе модель обучается на огромном количестве текстовых данных, чтобы научиться распознавать закономерности и особенности разной лексики и синтаксиса. Этот этап требует больших вычислительных мощностей и занимает длительное время.

Что такое GPT-нейросеть?

В основе работы GPT-нейросети лежит модель языка, которая предсказывает вероятность появления следующего слова или символа в тексте, исходя из предыдущего контекста. Для этого модель использует алгоритм трансформера, который позволяет улавливать зависимости и связи между словами и выстраивать логическую структуру предложений.

Процесс обучения GPT-нейросети состоит из двух этапов. Сначала модель представляется в виде слоя энкодера, который преобразует входные данные (текст) в скрытые представления. Затем эти представления передаются в слой декодера, который генерирует последовательность слов или символов в соответствии с заданным контекстом.

GPT-нейросети широко используются для автоматического генерирования текстов, автозаполнения и корректировки предложений, создания диалоговых систем и других задач обработки естественного языка. Благодаря своей гибкости и способности обучаться на большом объеме данных, GPT-нейросети считаются одними из наиболее эффективных моделей в области NLP (обработка естественного языка).

Описание и назначение GPT-нейросети

Основное назначение GPT-нейросети – создание искусственного интеллекта, который способен генерировать тексты с подобием естественного языка и обладать пониманием контекста. Это дает возможность использовать GPT во многих областях, включая машинное обучение, системы голосового управления, автозаполнение текстовых полей в приложениях, создание диалоговых систем и многое другое. Благодаря своей универсальности и гибкости, GPT-нейросеть находит все больше применений в реальном мире.

Алгоритм работы GPT-нейросети основан на трасформерах – архитектуре нейронных сетей, разработанной для обработки последовательностей данных, таких как тексты. Благодаря механизму внимания, трасформеры способны анализировать и улавливать связи между словами и даже предсказывать следующее слово в последовательности. GPT использует трасформеры для обучения и генерации текстов, что позволяет ему достигать удивительных результатов.

Для обучения GPT-нейросети используются множества данных, состоящие из текстовых корпусов. Чем больше данных, тем лучше качество и точность генерации текстов. GPT тренируется на суперкомпьютерах, которые способны параллельно обрабатывать огромные объемы данных. После обучения GPT становится готовой к использованию нейросетью, которая может быть интегрирована в различные системы и приложения.

| Преимущества GPT-нейросети: |

| - Высокое качество генерации текстов; |

| - Широкий спектр применения в различных областях; |

| - Универсальность и гибкость в использовании; |

| - Способность понимать контекст и генерировать связный текст; |

| - Активно поддерживается и развивается сообществом исследователей. |

Устройство и архитектура GPT-нейросети

Основная часть GPT состоит из нескольких слоев Transformer, каждый из которых включает механизм самовнимания (self-attention) для анализа контекста предыдущих слов и создания зависимостей между ними. Каждый слой Transformer состоит из нескольких подслоев, таких как механизм внимания и многоуровневая нейронная сеть.

Процесс работы GPT начинается с токенизации исходного текста на отдельные слова или фразы. Затем каждый токен проходит через эмбеддинг слой, который преобразует его в вектор фиксированной длины. Эти векторы подаются на вход слоев Transformer, где происходит обработка и анализ контекста.

После этого происходит генерация нового текста. GPT предсказывает вероятности следующих слов на основе предыдущего контекста и выбирает наиболее вероятное слово для дополнения предложения. Этот процесс повторяется до достижения заданного количества слов или пока не будет достигнут конец предложения.

GPT обучается на больших объемах текстовых данных, что позволяет ей узнавать общие закономерности языка и создавать грамматически верный и связный текст. Более того, GPT имеет возможность предсказывать контекст и продолжать фразы, что полезно для задач автодополнения текста и генерации продолжения диалога.

Таким образом, устройство и архитектура GPT-нейросети основаны на использовании слоев Transformer и механизма самовнимания для анализа и генерации текста. Это позволяет GPT генерировать высококачественный и связный текст, что делает ее полезной для различных задач обработки естественного языка.

Работа и принципы GPT-нейросети

Принцип работы GPT-нейросети основан на двух основных аспектах: предобучении и настройке. В начале процесса нейросеть проходит предобучение на большом объеме неструктурированных текстовых данных из интернета. Во время предобучения модель GPT учится предсказывать следующее слово в предложении на основе контекста. Это позволяет ей получить знание о синтаксисе, структуре и даже семантике языка.

После предобучения модель GPT дополнительно настраивается на конкретную задачу, например на генерацию текстов в определенной тематике. Для этого модель обучается на небольшом наборе текстов, специфичных для задачи, и тонко настраивается, чтобы генерированные тексты отвечали заданным критериям, таким как стиль, тон и смысл.

Одной из особенностей GPT-нейросети является ее способность генерировать продолжение текста на основе заданного контекста. Например, если пользователю нужно продолжить фразу или предложение, он может передать часть текста, а GPT-нейросеть сгенерирует продолжение, учитывая контекст и стилистику.

При работе GPT-нейросети важным аспектом является то, что в процессе генерации текста она не использует жестко заданные правила или шаблоны. Это позволяет ей создавать более оригинальные и гибкие тексты, которые могут быть приспособлены к различным сценариям и требованиям.

Использование GPT-нейросети распространено в различных областях, таких как обработка естественного языка, автоматическое создание контента, чат-боты и многое другое. Ее возможности в генерации текста сделали ее мощным инструментом в области искусственного интеллекта и нейронных сетей.

Ясно, что GPT-нейросеть является одной из самых мощных и интеллектуальных систем в области анализа и генерации текста. Ее работа основывается на предобучении и настройке, и она способна справиться с различными задачами, связанными с обработкой естественного языка.

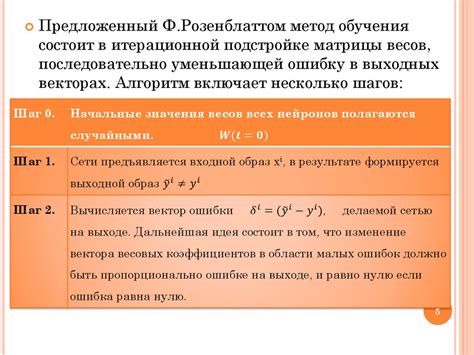

Алгоритмы обучения и функционирования GPT-нейросети

Алгоритмы обучения и функционирования GPT-нейросети (Generative Pre-trained Transformer) базируются на мощных моделях и сложных алгоритмах, которые позволяют нейросети генерировать автоматические тексты с высокой степенью подобия к человеческим.

Главным основополагающим алгоритмом GPT-нейросети является трансформер (Transformer). Трансформер – это модель глубокого обучения, в которой используются многоуровневые механизмы самообращения (self-attention) и многоуровневые механизмы внимания (multi-head attention) для обработки входных данных.

Алгоритм обучения GPT-нейросети включает в себя два основных этапа: предварительное обучение и дообучение.

Предварительное обучение заключается в том, что нейросеть обучается на большом объеме не размеченных текстов. В этом этапе модель пытается понять, как устроен естественный язык и как связаны его разные части. Таким образом, нейросеть приобретает общее представление о языке и его структуре, что позволяет ей генерировать качественные тексты.

Дообучение – это второй этап, на котором модель GPT-нейросети обучается на конкретных задачах, таких как машинный перевод, анализ тональности или генерация текста. В этом этапе нейросеть адаптируется к конкретным стилевым особенностям и контекстам задачи.

Алгоритм функционирования GPT-нейросети основан на применении модели к входному тексту и последующей генерации выходного текста. Модель разбивает входной текст на последовательность токенов и предсказывает вероятность следующего токена, используя контекст и предыдущие токены. Затем выбирается наиболее вероятный токен и добавляется к сгенерированному тексту. Процесс повторяется до достижения заданной длины генерируемого текста.

Для улучшения качества генерируемого текста GPT-нейросеть часто использует технику отсечения (top-k sampling), которая ограничивает количество рассматриваемых следующих токенов на каждом шаге генерации. Также может быть применена температурная настройка (temperature scaling), которая управляет разнообразием генерируемого текста.

Таким образом, алгоритмы обучения и функционирования GPT-нейросети объединяют в себе сложные технологии и методы, позволяющие создавать высококачественные модели генерации текста.

Применение GPT-нейросети в различных областях

Искусственный интеллект и нейросети на основе GPT (Generative Pre-trained Transformer) становятся все более широко используемыми в различных областях. Благодаря способности GPT-нейросети генерировать тексты, они стали особенно полезными в следующих областях:

- Языковые модели: GPT-нейросети могут быть использованы для создания различных языковых моделей. Они умеют генерировать текст, поддерживать диалоги и даже имитировать стиль конкретного автора.

- Автоматическое создание контента: GPT-нейросети могут быть использованы для автоматического создания текстового контента для блогов, новостных сайтов и других интернет-платформ. Это позволяет значительно сократить время и трудозатраты на создание уникального и качественного контента для веб-ресурсов.

- Машинный перевод: GPT-нейросети могут использоваться для автоматического перевода текстов с одного языка на другой. Благодаря обучению на больших объемах параллельных текстовых корпусов, они показывают высокую точность и качество перевода.

- Генерация кода: GPT-нейросети могут быть использованы для генерации программного кода на основе описания задачи или спецификации. Это может существенно ускорить процесс разработки программного обеспечения и повысить продуктивность разработчиков.

- Игровая индустрия: GPT-нейросети могут быть использованы для создания сценариев игр, искусственного интеллекта для врагов и союзников, генерации уровней и многого другого. Это позволяет создавать более реалистичные и качественные игровые миры.

Применение GPT-нейросети в различных областях позволяет существенно повысить эффективность и качество работы, сократить время и ресурсы на рутинные задачи и расширить возможности искусственного интеллекта. Будущее GPT-нейросетей остается ярким и перспективным, и их роль в различных областях только возрастает.