В мире информационных технологий размер символа играет важную роль при обработке и хранении данных. Каждый символ, который мы видим на экране, занимает определенное количество памяти. Понимание связи между размером символа и байта позволяет эффективно использовать ресурсы и оптимизировать процессы.

Символы в компьютерных системах представлены в виде числовых кодов, называемых кодировками. Наиболее распространенной является UTF-8, которая позволяет представлять символы разных письменностей в единой кодировке. Однако, размер символа будет зависеть как от кодировки, так и от типа символа.

Размер символа определяется в байтах. Традиционно байт состоит из 8 бит. В UTF-8 символы могут занимать от 1 до 4 байт, где самые распространенные символы занимают 1 байт, а редкие - 4 байта. Однако, в других кодировках размер символа может быть отличным.

Понимание параметров, влияющих на размер символа и байта, помогает при разработке и оптимизации программного обеспечения, работы с базами данных и веб-страницами. Размер символа и байта - это важные концепции, которые необходимо учитывать при работе с информацией в цифровой эпохе.

Символы и их размеры

Символы в компьютерах представлены с помощью чисел, которые называются кодами символов. Каждому символу соответствует определенный код, который определяет его идентификатор и способ отображения.

В зависимости от кодировки символов различного языка или стандарта, размер символа может различаться. Так, в некоторых кодировках символы занимают 1 байт, а в других - 2, 3 или даже 4 байта.

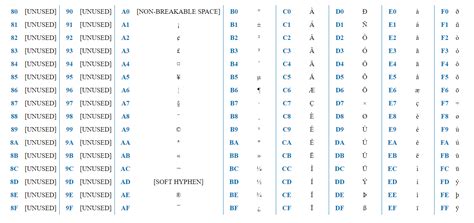

Например, в стандартной кодировке ASCII каждому символу соответствует 1 байт, а коды символов находятся в диапазоне от 0 до 127 (включительно). Это позволяет представить основные английские символы, цифры и специальные символы.

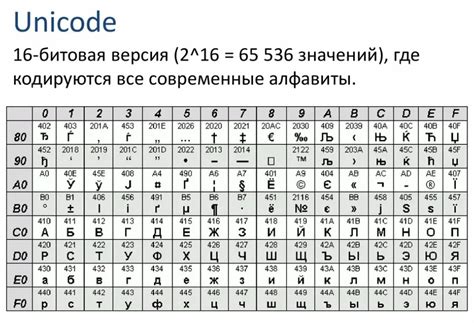

Однако для представления символов различных языков, таких как русский, китайский или арабский, требуется использовать другие кодировки, например, UTF-8 или UTF-16.

Кодировка UTF-8 использует переменное количество байт для представления символов, в зависимости от их кода. В большинстве случаев символы занимают 1 байт, но есть и символы, которые занимают 2, 3 или 4 байта.

Кодировка UTF-16 использует всегда по 2 байта для представления символов, что делает ее более простой, но и более "тяжелой" по сравнению с UTF-8.

Размер символа и байта имеют прямую связь, в зависимости от используемой кодировки символов. Правильный выбор кодировки позволяет корректно отображать символы различных языков и обеспечивает совместимость текстового содержимого.

Байты и их влияние

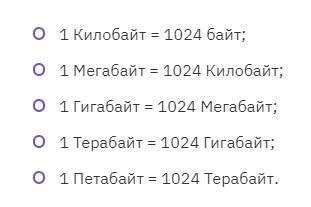

Байты применяются в различных областях, таких как хранение данных, передача информации по сети, работа с файлами и многое другое. Чтобы узнать, сколько информации может быть содержаться в определенном количестве байтов, используются префиксы, такие как килобайт (KB), мегабайт (MB), гигабайт (GB).

Размер байта также влияет на производительность и эффективность программ и устройств. При работе с большими объемами данных, эффективное использование байта может существенно ускорить обработку информации и снизить затраты ресурсов.

Знание размера байта и его влияние на работу компьютерных систем является необходимым для разработчиков программного обеспечения, системных администраторов и других специалистов, связанных с компьютерной технологией. Умение эффективно использовать и оптимизировать работу с байтами может значительно повысить производительность и эффективность работы с компьютерной информацией.

Размер символа в кодировке UTF-8

Основная идея кодировки UTF-8 заключается в том, что символы с низкими кодами (до 128) представляются одним байтом, в то время как символы с более высокими кодами представляются последовательностью из двух, трех или четырех байтов. Это позволяет кодировать символы из разных языков, включая русский, английский, китайский и другие.

| Количество байтов | Диапазон кодов | Примеры символов |

|---|---|---|

| 1 | 0-127 | ASCII символы, например, 'A', 'B', 'C' |

| 2 | 128-2047 | Кириллические символы, например, 'А', 'Б', 'В' |

| 3 | 2048-65535 | Иероглифы, например, '中', '日', '本' |

| 4 | 65536-1114111 | Эмодзи, например, '', '', '' |

Размер символа в кодировке UTF-8 является гибким и эффективным, так как позволяет экономить память, особенно при работе с текстом, содержащим символы разных языков и иероглифы. Знание размера символа в кодировке UTF-8 поможет программистам и разработчикам правильно обрабатывать строки и выполнять необходимые операции над символами.

Изменение размера символа в кодировке UTF-16

Кодировка UTF-16 используется для представления символов в компьютерных системах. В этой кодировке каждый символ занимает 2 байта. Однако, размер символа может быть изменен, чтобы удовлетворить определенные требования.

Для изменения размера символа в кодировке UTF-16 можно воспользоваться двумя методами:

- Использование суррогатной пары: Суррогатная пара состоит из двух 16-битных кодовых единиц. Сначала устанавливается высший диапазон кодов, а затем нижний. Это позволяет использовать большее число символов, чем в стандартном 2-байтном представлении.

- Использование кодирования переменной длины: Кодирование переменной длины позволяет представлять символы различной длины. Вместо фиксированного размера символа, символы кодируются переменным количеством байтов, что позволяет использовать различные размеры символов в зависимости от их значения.

Изменение размера символа может быть полезно, например, при работе с различными алфавитами или при использовании символов, которые не поддерживаются стандартной кодировкой UTF-16.

Однако, при изменении размера символа следует учитывать возможные проблемы совместимости и сложности обработки символов в таком формате. Не все программы и системы могут корректно обрабатывать суррогатные пары или кодирование переменной длины.

При использовании измененного размера символа в кодировке UTF-16 следует обратить внимание на совместимость и поддержку данного формата программным обеспечением, с которым предполагается работать.

Влияние размера символа на скорость работы программы

Размер символа имеет прямое влияние на скорость работы программы. Чем больше размер символа, тем больше памяти требуется для хранения и обработки данных, что может существенно замедлить выполнение программы.

В программировании размер символа измеряется в байтах. Каждый символ в кодировке занимает определенное количество байт. Например, в ASCII кодировке один символ занимает один байт, а в UTF-8 кодировке размер символа может варьироваться от 1 до 4 байтов в зависимости от его кода.

При обработке большого количества данных, особенно текстовых, выбор кодировки и размера символа становится критическим. Неоправданно большой размер символа может привести к значительному увеличению объема используемой памяти и, как следствие, замедлению работы программы.

Оптимальный выбор размера символа зависит от особенностей конкретной задачи и требований к программе. В некоторых случаях можно использовать уменьшенные версии кодировок, где символы занимают меньше памяти, например, UTF-16 вместо UTF-8. Однако это может привести к ограничению набора символов, которые можно использовать.

Важно учитывать влияние размера символа на скорость работы программы уже на этапе проектирования, чтобы избежать проблем с производительностью в будущем. Беспроблемное выполнение операций с символами требует внимательного анализа и оптимизации размера символа и выбора кодировки.