Нейронные сети стали неотъемлемой частью многих сфер человеческой деятельности, от распознавания образов до автоматического перевода. Однако, для их эффективной работы требуется большой объем данных для обучения. Создание качественного датасета является важным шагом на пути к успешной тренировке нейронной сети.

В этой статье мы рассмотрим, как создать датасет для нейронной сети на языке программирования Python. Мы рассмотрим все этапы: от сбора данных до их подготовки и организации в формате, удобном для обучения нейронной сети. Процесс будет пошаговым, и даже если у вас нет опыта в работе с нейронными сетями, вы сможете легко следовать нашей инструкции.

Первый этап - сбор данных. Необходимо определить, какие данные вам необходимы для вашей задачи. Это может быть любая информация: изображения, тексты, аудиофайлы и т.д. Рекомендуется собирать достаточно разнообразные данные, чтобы ваша нейронная сеть обладала общими представлениями о предмете.

Продолжение следует...

Подготовка данных для нейронной сети

1. Загрузка данных: начните с загрузки данных, которые вы хотите использовать для обучения нейронной сети. Данные могут быть представлены в разных форматах, таких как CSV (Comma-Separated Values), Excel или JSON. В зависимости от формата данных, вам может потребоваться использовать специальные библиотеки для чтения и обработки данных.

2. Предварительная обработка данных: прежде чем передать данные в нейронную сеть, необходимо выполнить некоторую предварительную обработку данных. Это может включать в себя удаление выбросов, заполнение пропущенных значений, нормализацию данных и масштабирование. Цель состоит в том, чтобы сделать данные пригодными для обучения нейронной сети.

3. Разделение данных: после предварительной обработки данных, следующим шагом является разделение данных на обучающую и тестовую выборки. Обучающая выборка будет использоваться для обучения нейронной сети, тестовая выборка - для проверки качества обучения. Обычно используется пропорция 70-30 или 80-20 для разделения данных.

4. Кодировка данных: если ваши данные содержат категориальные переменные (например, цвет, размер), их необходимо закодировать в числовой формат. Это можно сделать с помощью методов, таких как One-Hot Encoding или Label Encoding, чтобы нейронная сеть могла правильно интерпретировать эти переменные.

5. Форматирование данных: перед тем, как передать данные в нейронную сеть, убедитесь, что они имеют правильный формат. Например, данные могут быть представлены в виде массивов или таблиц. Убедитесь, что данные имеют правильный размер и тип.

6. Создание датасета: наконец, объедините все данные в датасет. Датасет должен состоять из обучающих данных и соответствующих им меток, которые вы хотите предсказать. Проверьте, что датасет имеет правильный формат и доступен для использования нейронной сетью.

| Шаг | Описание |

|---|---|

| Загрузка данных | Загрузка данных для обучения нейронной сети |

| Предварительная обработка данных | Обработка данных перед использованием в нейронной сети |

| Разделение данных | Разделение данных на обучающую и тестовую выборки |

| Кодировка данных | Преобразование категориальных переменных в числовой формат |

| Форматирование данных | Проверка и приведение данных к правильному формату |

| Создание датасета | Объединение данных и меток в датасет |

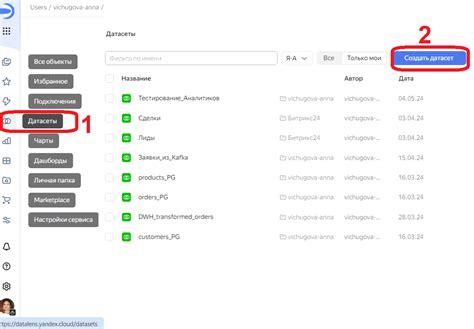

Выбор источника данных для датасета

- Открытые наборы данных: В интернете существует множество открытых источников данных, включающих такие ресурсы, как Kaggle, UCI Machine Learning Repository, Google Dataset Search и многие другие. Эти наборы данных уже собраны и предоставляются для свободного использования. Они могут содержать данные из различных сфер, таких как финансы, медицина, спорт, социальные науки и т. д. Однако, перед использованием открытых наборов данных, важно внимательно ознакомиться с их описанием и проверить качество и достоверность данных.

- Собственно собранные данные: Если вам необходимы данные, специфичные для вашей задачи, то вы можете самостоятельно собирать данные при помощи веб-скрапинга или анализа открытых источников с помощью API (Application Programming Interface). Например, вы можете использовать API социальных сетей, чтобы получить данные о пользовательских профилях или использовать веб-скрапинг для получения информации с веб-сайтов.

- Автоматическое создание данных: В некоторых случаях вы можете использовать генеративные модели для автоматического создания данных. Например, если вам нужны изображения лиц для обучения нейронной сети распознаванию лиц, вы можете использовать генеративные модели, чтобы создать синтетические изображения.

Независимо от выбранного источника данных, важно убедиться, что данные достаточно разнообразны и представляют все возможные сценарии, которые вы можете столкнуться в реальных условиях. Также необходимо обратить внимание на размер и чистоту данных, так как качество датасета может оказать существенное влияние на результаты обучения нейронной сети.

Сбор данных с использованием Python

Один из простых способов собирать данные - это парсинг веб-страниц. Библиотеки, такие как BeautifulSoup и requests, предоставляют удобные инструменты для извлечения информации из HTML-кода страницы.

Еще один способ сбора данных - это использование API. Многие платформы предоставляют программный интерфейс, через который можно получать данные напрямую. Например, Twitter и Instagram предоставляют API для доступа к данным пользователей.

Если нужно собрать данные из большого количества файлов, можно воспользоваться модулем os. Он позволяет программно обходить директории и файлы на компьютере, извлекая нужные информацию.

При сборе данных необходимо учитывать правовые и этические аспекты. Важно не нарушать авторские права и не использовать личную информацию без согласия пользователей.

После сбора данных, необходимо провести их первичную обработку и фильтрацию. Будьте внимательны к возможным ошибкам и выбросам в данных. Также, может понадобиться провести аугментацию данных, чтобы расширить их разнообразие.

В итоге, для создания датасета для нейронной сети с использованием Python необходимо правильно собрать данные из различных источников, провести их обработку и подготовить в требуемом формате.

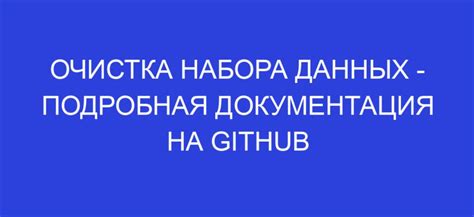

Очистка и предобработка данных

Прежде чем приступить к созданию датасета для нейронной сети, необходимо провести очистку и предобработку данных. Это важный шаг, который позволяет устранить ошибки и шумы, привести данные к единому формату и подготовить их для дальнейшего анализа.

Очистка данных включает в себя удаление или замену некорректных, отсутствующих или выбросных значений. Для этого можно использовать различные методы, например, удаление строк или столбцов с отсутствующими значениями, заполнение пропусков средними или медианными значениями, а также устранение выбросов на основе статистических методов.

Предобработка данных включает в себя преобразование категориальных признаков в числовые, масштабирование данных, а также нормализацию и стандартизацию значений. Это позволяет повысить качество модели и улучшить ее обучение.

Очистка и предобработка данных также включают проверку и удаление дубликатов, удаление лишних признаков или объединение нескольких признаков в один, а также приведение значений к правильному формату или единому стандарту.

В Python для очистки и предобработки данных можно использовать различные библиотеки, такие как Pandas, NumPy или Scikit-learn. Эти библиотеки предоставляют широкий набор функций и методов для работы с данными и их обработки.

Очистка и предобработка данных являются важной частью процесса создания датасета для нейронной сети. Хорошо очищенные и предобработанные данные позволяют получить более точные и надежные результаты при обучении нейронной сети и анализе данных.

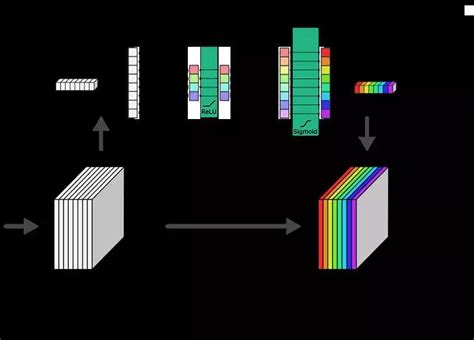

Аугментация данных для улучшения обучения

Аугментация данных может помочь решить проблему переобучения, когда модель слишком хорошо запоминает датасет и плохо обобщает знания на новые данные. Применение случайных преобразований к обучающим образцам позволяет расширить разнообразие данных, имитируя изменения, которые могут возникнуть в реальных ситуациях.

Существует множество различных техник аугментации данных, включая:

- Горизонтальное отражение (зеркальное отображение) изображений;

- Случайное поворот изображений на небольшой угол;

- Добавление шума к изображениям;

- Изменение яркости, контрастности или насыщенности изображений;

- Случайное обрезание изображений;

Такие трансформации позволяют модели обучаться на более разнообразных данных и снижают риск переобучения. Они способствуют увеличению обобщающей способности моделей, повышают их устойчивость к изменениям в данных и помогают достичь лучших результатов на новых, незнакомых образцах.

Аугментация данных на Python может быть реализована с помощью различных библиотек, таких как TensorFlow, Keras, imgaug, Albumentations и другие. Они предоставляют разнообразные функции для преобразования изображений, аудиофайлов или текстовых данных.

Важно помнить, что аугментация данных должна применяться к обучающему набору данных, а не к тестовому или валидационному набору. Это гарантирует, что модель будет обучаться на разнообразных данных, но оцениваться на чистых, неизмененных образцах, что делает результаты более объективными.

Создание датасета для нейронной сети

Создание датасета - это процесс сбора, подготовки и организации данных для обучения модели. От качества и разнообразия данных в датасете зависит эффективность обучения модели и ее способность обобщать на новые данные.

Перед началом создания датасета необходимо определить цели и задачи модели, которая будет обучаться на этом датасете. Например, если модель предназначена для классификации изображений, необходимо подготовить датасет, состоящий из изображений и их соответствующих меток классов.

Сбор данных для датасета может происходить различными способами: из интернета, с использованием специализированных датасетов, собранных другими исследователями или при помощи собственных экспериментов и измерений.

Однако просто собрать данные недостаточно. Данные необходимо подготовить и предобработать перед их использованием в модели. В зависимости от задачи и типа данных это может включать в себя очистку данных (удаление шума, исправление ошибок и выбросов), репрезентацию данных в удобной форме (например, преобразование изображений в числовые признаки), нормализацию данных (приведение признаков к одному и тому же масштабу) и другие преобразования.

После предобработки данных необходимо разделить их на обучающую и проверочную выборки. Это позволит оценить качество обученной модели на независимых данных и избежать переобучения (ситуации, когда модель хорошо справляется с обучающими данными, но плохо справляется с новыми данными).

Итак, создание датасета для нейронной сети - это сложный и ответственный процесс, требующий тщательной подготовки и организации данных. Качественный и разнообразный датасет является ключевым фактором успеха при обучении нейронной сети и достижении желаемых результатов.