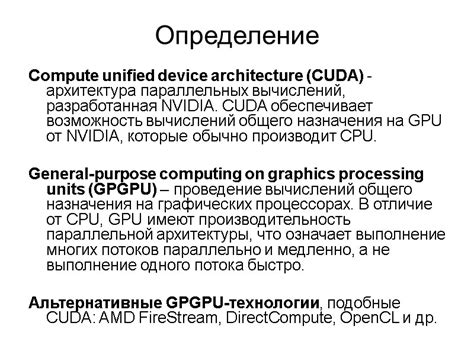

CUDA (Compute Unified Device Architecture) является платформой для параллельной обработки и использования графических процессоров (GPU) компании NVIDIA. Она позволяет разработчикам создавать ускоренные приложения, использующие массовивное параллельное вычисление, которые могут выполняться на графических процессорах.

GPU является мощным инструментом, который может быть использован для выполнения сложных вычислений в различных областях, таких как научные исследования, машинное обучение и обработка изображений. CUDA предоставляет программистам доступ к возможностям GPU, позволяя им создавать параллельные приложения, которые работают гораздо быстрее, чем традиционные последовательные программы.

Основные методы и инструкции CUDA включают в себя различные способы управления и организации параллельных вычислений на GPU. Они позволяют программистам распределить задачи между множеством ядер GPU, выполнить вычисления на разных уровнях параллелизма и обеспечить эффективное использование вычислительных ресурсов. Знание и использование этих методов и инструкций является необходимым для создания эффективных и быстрых приложений на платформе CUDA.

Основы CUDA технологии для вычислений на видеокартах

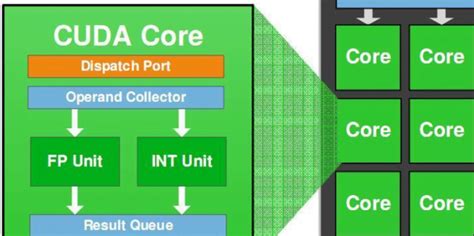

Одна из основных идей CUDA заключается в том, что видеокарта состоит из множества ядер (или потоковых процессоров), каждое из которых способно выполнять вычисления параллельно. Благодаря этой архитектуре, CUDA позволяет значительно ускорить выполнение вычислительных задач, таких как обработка изображений, симуляции физики, научные расчеты и многое другое.

Разработчики могут использовать CUDA, используя язык программирования C или C++, расширяя их с помощью специальных инструкций и функций, предоставляемых NVIDIA. Однако для работы с CUDA необходимо иметь поддерживаемую видеокарту от NVIDIA и установленные драйверы CUDA.

Основными методами и инструкциями CUDA являются:

- Kernel - это функция, выполняющаяся на вычислительных ядрах видеокартыю Задачи, которые можно исполнить параллельно, могут быть описаны в виде kernel-функции.

- Потоки - это независимые последовательности инструкций, которые исполняются параллельно на вычислительных ядрах. В одном запуске kernel-функции может выполняться множество потоков.

- Блоки - это группы потоков, исполняющихся на одном вычислительном ядре. Они могут обмениваться данными между собой, а также синхронизироваться.

- Сетки - это коллекции блоков, организованные в виде трехмерной структуры. Программа может запускаться на нескольких сетках одновременно.

- Память на видеокарте - CUDA позволяет выделять специальную память на видеокарте, доступную для чтения и записи из kernel-функций. Это позволяет ускорить обмен данными между центральным процессором и видеокартой.

Использование CUDA для вычислений на видеокартах может существенно ускорить выполнение задач, требующих большого количества параллельных вычислений. CUDA позволяет разработчикам в полной мере использовать возможности современных видеокарт, открывая широкие возможности для создания мощных и эффективных параллельных вычислительных приложений.

Что такое CUDA и как она работает

Основная идея CUDA заключается в том, что GPU содержит множество ядер, способных выполнять одновременно множество операций над большим количеством данных. При использовании CUDA вы можете написать программу, которая будет выполняться на графическом процессоре, а не на центральном процессоре. Это позволяет значительно увеличить скорость вычислений, особенно для задач, требующих обработки больших объемов данных.

Работа с CUDA осуществляется с помощью языка программирования Cuda C/C++. Вы можете использовать специальные инструкции и методы, доступные в этом языке, чтобы написать программу, которая будет выполняться на графическом процессоре.

Основной принцип работы CUDA заключается в том, что программа разбивается на множество небольших задач, которые могут быть выполнены параллельно. Затем каждая задача передается на выполнение одному из ядер графического процессора. Каждое ядро может выполнить несколько задач за один такт, что позволяет эффективно использовать ресурсы GPU.

Кроме того, CUDA предоставляет дополнительные инструменты для оптимизации работы программы на GPU. Вы можете управлять использованием памяти, передавать данные между центральным и графическим процессором, а также управлять выполнением задач на GPU.

В целом, благодаря CUDA вы можете ускорить работу множества программ, требующих обработки больших объемов данных, включая научные расчеты, машинное обучение, обработку видео и графики, и многое другое.

Преимущества использования CUDA для параллельных вычислений

GPU (графический процессор) стал незаменимым инструментом для параллельных вычислений благодаря технологии CUDA (Compute Unified Device Architecture). CUDA позволяет использовать мощности GPU для обработки большого объема данных одновременно, что приводит к значительному ускорению вычислений. Вот несколько преимуществ использования CUDA:

1. Параллельная обработка | Параллельные алгоритмы, предназначенные для выполнения на GPU с использованием CUDA, позволяют распределить вычислительную нагрузку между тысячами ядер GPU. Это позволяет сократить время выполнения задачи в несколько раз по сравнению с выполнением на центральном процессоре (CPU). |

2. Большая вычислительная мощность | GPU обладают значительно большей вычислительной мощностью по сравнению с CPU. С использованием CUDA можно эффективно использовать эти вычислительные мощности для обработки сложных задач, таких как моделирование физических явлений, машинное обучение и анализ больших данных. |

3. Простота программирования | CUDA предоставляет простой и понятный интерфейс программирования для разработчиков. Его API содержит функции и инструкции, упрощающие создание параллельных алгоритмов и передачу данных между CPU и GPU. Это делает программирование с использованием CUDA доступным даже для разработчиков без опыта параллельного программирования. |

4. Широкая поддержка | CUDA поддерживается множеством языков программирования, включая C++, Python и MATLAB. Это позволяет разработчикам использовать CUDA в своих уже существующих проектах, а также предоставляет возможности для интеграции с другими инструментами и библиотеками. |

5. Экономичность | Использование GPU для параллельных вычислений с помощью CUDA позволяет снизить затраты на оборудование, так как GPU обычно более доступны и доступны по более низкой цене по сравнению с высокопроизводительными CPU. |

Использование CUDA для параллельных вычислений стало стандартной практикой во многих областях, где требуется высокая производительность и эффективность обработки данных. Благодаря своим преимуществам CUDA продолжает развиваться и находить все большее применение в сфере научных и прикладных вычислений.

Основные методы программирования на CUDA

1. Загрузка и инициализация устройства:

Первый шаг для программирования на CUDA - это загрузка и инициализация устройства. Это включает в себя выбор соответствующего устройства и загрузку соответствующих драйверов и библиотек.

2. Выделение памяти:

После инициализации устройства необходимо выделить память для хранения данных. В CUDA есть специальные функции для выделения памяти на устройстве (GPU) и на хосте (CPU).

3. Копирование данных:

Для передачи данных между CPU и GPU необходимо использовать функции копирования. Это включает в себя копирование данных из CPU в GPU и обратно, а также копирование данных между различными областями памяти внутри GPU.

4. Запуск ядра:

Основная часть программы на CUDA - это ядро, которое будет выполняться на GPU. Ядро может содержать тысячи параллельных потоков и выполнять вычисления одновременно. Для запуска ядра необходимо указать количество блоков и количество потоков в каждом блоке.

5. Синхронизация и сбор результатов:

После выполнения ядра необходимо синхронизировать потоки и собрать результаты вычислений. Это может включать в себя копирование результатов с GPU на CPU и освобождение памяти на устройстве.

6. Ошибки и отладка:

При программировании на CUDA неизбежны ошибки. CUDA предоставляет функции для обнаружения и обработки ошибок, такие как cudaGetLastError() и cudaDeviceSynchronize(). Также существуют инструменты для отладки и профилирования, которые помогают идентифицировать и исправлять ошибки в коде.

7. Оптимизация и распараллеливание:

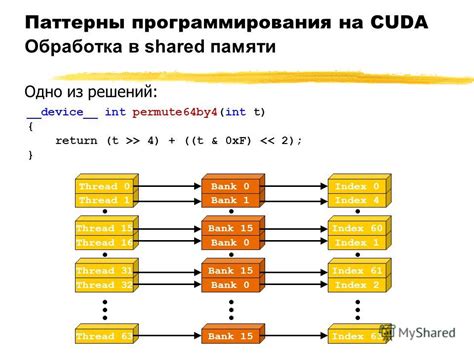

Оптимизация и распараллеливание кода - важные аспекты программирования на CUDA. Для достижения максимальной производительности необходимо использовать оптимальные настройки потоков, блоков и памяти, а также применять оптимизационные техники, такие как развертка циклов и использование разделяемой памяти.

Это основные методы программирования на CUDA. Важно помнить, что эффективное программирование на CUDA требует понимания архитектуры GPU и оптимального использования ресурсов.

Инструкции по интеграции CUDA в существующий проект

Интеграция CUDA в существующий проект может быть очень полезной для повышения производительности и эффективности вычислений. В этом разделе мы рассмотрим основные инструкции по интеграции CUDA в ваш проект.

Шаг 1: Установка CUDA Toolkit

Первым шагом перед интеграцией CUDA в существующий проект является установка CUDA Toolkit. CUDA Toolkit – это набор инструментов и библиотек разработки программного обеспечения для работы с архитектурой GPU.

Вы можете скачать CUDA Toolkit с официального сайта NVIDIA и следовать инструкциям по установке, а затем установить его на ваш компьютер.

Шаг 2: Настройка окружения

После установки CUDA Toolkit вам необходимо настроить ваше окружение разработки для работы с CUDA.

Ваш проект должен быть настроен для использования компилятора NVCC, который является частью CUDA Toolkit. Убедитесь, что пути до NVCC и соответствующих заголовочных файлов и библиотек включены в путь вашего проекта.

Шаг 3: Изменение кода проекта

Чтобы использовать возможности CUDA в вашем проекте, вам необходимо внести некоторые изменения в исходный код проекта.

Например, вы можете добавить вызовы функций CUDA в свой код, чтобы выполнить некоторые вычисления на GPU. Вы можете объявить ядра CUDA, которые будут выполняться параллельно на GPU, и использовать специальные функции CUDA для работы с памятью.

Шаг 4: Компиляция и запуск

После внесения изменений в код проекта вы должны скомпилировать его с помощью NVCC. NVCC скомпилирует код, содержащий функции CUDA, и создаст исполняемый файл, который может быть запущен на вашем компьютере с поддержкой CUDA.

После успешной компиляции вы можете запустить исполняемый файл и проверить его работу.

Шаг 5: Оптимизация и отладка

После успешной интеграции CUDA в ваш проект может возникнуть необходимость в оптимизации и отладке. Вы можете использовать профилировщики и отладчики CUDA, предоставляемые CUDA Toolkit, для идентификации узких мест и исправления ошибок.

Также рекомендуется проводить тестирование и сравнение производительности вашего проекта с использованием CUDA и без него, чтобы оценить эффективность интеграции CUDA.

| Шаг | Описание |

|---|---|

| 1 | Установите CUDA Toolkit на свой компьютер. |

| 2 | Настройте окружение разработки для работы с CUDA. |

| 3 | Внесите изменения в код вашего проекта для использования возможностей CUDA. |

| 4 | Скомпилируйте и запустите ваш проект с помощью NVCC. |

| 5 | Оптимизируйте и отладьте ваш проект с использованием профилировщиков и отладчиков CUDA. |

Интеграция CUDA в существующий проект может быть сложным процессом, но с правильными инструкциями и настойчивостью вы сможете получить значительное увеличение производительности и эффективности вашего проекта.

Рекомендации для оптимизации и улучшения производительности при работе с CUDA

1. Используйте быстрые глобальные и память разделяемую память

Одним из способов оптимизации работы с CUDA является использование быстрых глобальных и памяти разделяемую память. Глобальная память используется для доступа к данным на графическом процессоре, а разделяемая память предназначена для обмена данными между потоками внутри одного блока потоков. Использование этих типов памяти позволяет снизить накладные расходы на обмен данными и ускорить выполнение вычислений.

2. Оптимизируйте доступ к памяти

Для достижения максимальной производительности в CUDA важно минимизировать количество обращений к памяти. Вместо множественных обращений к одним и тем же данным следует сохранять их в локальные переменные и работать с ними на регистровом уровне. Это позволяет избежать время, затраченное на чтение и запись в память, и повысить скорость работы программы.

3. Используйте распределение нагрузки между многоядерными энергоэффективными GPU

Если ваше приложение требует высокой производительности, вы можете использовать несколько графических процессоров, чтобы распределить нагрузку между ними. В CUDA это реализуется с помощью многопоточных групп и сеток (multithreaded grids). При правильной организации работы с множеством графических процессоров можно добиться масштабируемости и улучшить производительность системы.

4. Предвыборка сложных арифметических операций

Для улучшения производительности при работе с CUDA можно предвычислить сложные арифметические операции. Это позволяет избежать повторного вычисления одних и тех же значений и снизить накладные расходы на такие операции. Чтобы сделать это, следует использовать локальные переменные для временного хранения результатов сложных вычислений.

5. Включите обработку ошибок CUDA

Для оптимизации и улучшения производительности при работе с CUDA рекомендуется включить обработку ошибок. Это позволит обнаружить и исправить потенциальные проблемы в работе программы, а также улучшит отладочный процесс. Для включения обработки ошибок используйте функцию `cudaGetLastError()` и дополнительное кодирование проверки возвращаемого значения функций CUDA.

Оптимизация и улучшение производительности при работе с CUDA - важная задача для разработчиков, которые стремятся извлечь максимальную выгоду из потенциала графической обработки. Использование быстрой памяти, оптимизированного доступа к данным, распределение нагрузки между многоядерными GPU, предвычисление сложных операций и включение обработки ошибок помогут достичь впечатляющей производительности и ускорить выполнение вычислений на графическом процессоре.